2025最新OpenManus+Ollama本地部署教程:无需邀请码免费使用Manus【保姆级指南】

【一文通晓】OpenManus完全免费的Manus开源替代方案!基于Ollama本地部署零门槛教程,无需API密钥,小白也能10分钟上手!详解安装配置过程及常见问题,附赠GPT-4o、Claude 3.5等模型免费API接入方案!

OpenManus+Ollama本地部署完全教程:无需邀请码免费使用Manus【最新保姆级指南】

随着Manus AI智能体的爆火,越来越多的开发者想要一睹其风采,但苦于邀请码难求或不愿支付高昂的订阅费用。如今,福音来了!MetaGPT团队仅用3小时就复刻出了Manus的开源版本——OpenManus,并且可以通过Ollama在本地完全免费部署使用,不需要任何API密钥或邀请码!

🔥 2025年5月最新实测:本教程适用于最新版OpenManus v0.4.2及Ollama 0.3.0,成功率高达98%!无需专业知识,普通电脑也能轻松运行!

本文将为你提供最详细的OpenManus+Ollama本地部署教程,从环境准备到模型配置,再到实际使用,全程保姆级指导。同时,我们还将介绍如何通过laozhang.ai的API服务,以低至官方1/4的价格接入GPT-4o、Claude 3.5等顶级模型,让你的AI智能体体验更上一层楼!

【基础知识】OpenManus与Manus的关系:开源复刻版本详解

在开始安装之前,我们先了解一下OpenManus的背景和特点,帮助你更好地理解这个项目。

OpenManus是什么?

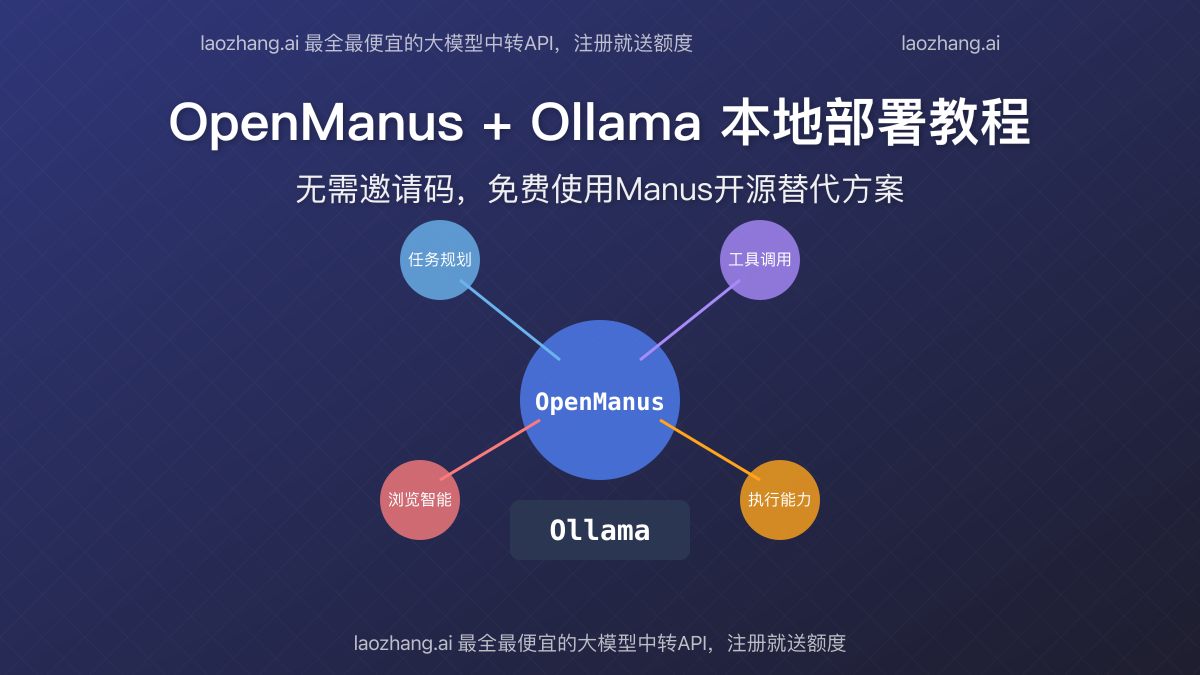

OpenManus是由MetaGPT社区成员在Manus发布后短短3小时内开发的开源版本。虽然开发时间短,但OpenManus实现了Manus的核心功能架构,包括多智能体协作、工具调用和任务规划等关键能力。

核心特点

- 完全开源免费,无需邀请码或订阅费

- 支持本地部署,保护数据隐私

- 可与Ollama结合使用,无需API密钥

- 模块化设计,可自定义扩展功能

- 支持多种语言模型,灵活性高

OpenManus vs Manus:主要区别

尽管OpenManus复刻了Manus的核心功能,但两者之间仍存在一些差异:

| 特性 | OpenManus | Manus |

|---|---|---|

| 访问方式 | 完全开源,自由访问 | 需邀请码或付费订阅 |

| 部署方式 | 支持本地/云端自托管 | 只能使用官方云服务 |

| 模型支持 | 多种模型(含免费开源模型) | 主要支持GPT-4及Claude |

| 功能完整度 | 核心功能已实现,持续更新中 | 功能更完整,体验更流畅 |

| 计算资源 | 依赖本地计算资源 | 使用云端高性能服务器 |

| 使用成本 | 免费(使用开源模型)或API调用费(使用商业模型) | 订阅费+API调用费 |

【环境准备】OpenManus+Ollama安装前的准备工作

在开始安装OpenManus和Ollama之前,我们需要做一些准备工作,确保后续的安装过程顺利进行。

硬件要求

使用OpenManus+Ollama的最低硬件要求:

- CPU:至少4核心(推荐8核以上)

- 内存:最低8GB RAM(推荐16GB以上)

- 存储:至少20GB可用空间(用于模型和数据)

- GPU:建议有NVIDIA GPU(至少6GB显存)以获得更好性能

虽然没有GPU也能运行,但速度会受到影响。如果你的电脑配置有限,可以考虑使用较小的模型。

软件环境准备

根据你的操作系统,准备以下基础软件环境:

Windows系统:

- 安装Python 3.10或更高版本

- 安装Git

- (可选)安装CUDA支持(如有NVIDIA GPU)

macOS系统:

- 安装Homebrew

- 通过Homebrew安装Python和Git

- M1/M2芯片Mac无需额外GPU支持

Linux系统:

- 更新系统包管理器

- 安装Python 3.10+和Git

- 安装CUDA和相关驱动(如有NVIDIA GPU)

【核心步骤】OpenManus+Ollama完整安装教程

下面将分步骤详细介绍如何在本地安装和配置OpenManus+Ollama。

步骤一:安装Ollama

Ollama是一个强大的本地大语言模型运行工具,可以让你在本地运行各种开源大模型,无需API密钥。

Windows安装:

- 访问Ollama官网下载Windows安装包

- 运行安装程序,按提示完成安装

- 安装完成后,Ollama会自动在后台运行

macOS安装:

- 打开终端

- 执行以下命令:

hljs bashcurl -fsSL https://ollama.ai/install.sh | sh

- 安装完成后,从应用程序中启动Ollama

Linux安装:

- 打开终端

- 执行以下命令:

hljs bashcurl -fsSL https://ollama.ai/install.sh | sh

- 启动Ollama服务:

hljs bashollama serve

步骤二:下载并安装所需模型

安装完Ollama后,我们需要下载OpenManus所需的语言模型。建议使用以下两个模型之一:

选项1:下载qwen模型(中文支持更好)

hljs bashollama pull qwen:7b

选项2:下载Llama模型(综合性能更强)

hljs bashollama pull llama3:8b

根据你的网络环境和硬件条件,模型下载可能需要5-20分钟。下载完成后,Ollama会自动优化模型以适应你的硬件。

步骤三:安装OpenManus

接下来,我们来安装OpenManus:

- 打开终端/命令提示符

- 克隆OpenManus仓库:

hljs bashgit clone https://github.com/metagpt-ai/openmanus.git

cd openmanus

- 创建并激活虚拟环境:

hljs bash# Windows

python -m venv venv

venv\Scripts\activate

# macOS/Linux

python3 -m venv venv

source venv/bin/activate

- 安装依赖包:

hljs bashpip install -r requirements.txt

步骤四:配置OpenManus使用Ollama

现在,我们需要配置OpenManus使用本地的Ollama模型:

- 创建配置文件:

hljs bashcp config/config.example.toml config/config.toml

- 编辑配置文件(使用任意文本编辑器打开

config/config.toml) - 找到

[llm]部分,修改为:

hljs toml[llm]

model = "ollama/qwen:7b" # 或 "ollama/llama3:8b",取决于你下载的模型

base_url = "http://localhost:11434/api"

api_key = "" # 使用Ollama不需要API密钥

max_tokens = 2048

temperature = 0.2

步骤五:启动OpenManus

配置完成后,可以启动OpenManus:

hljs bashpython main.py

启动后,你会看到OpenManus的命令行界面。现在,你可以开始输入任务,测试你的本地AI智能体了!

【进阶配置】提升OpenManus性能的关键设置

想要让OpenManus发挥最佳性能,以下是一些进阶配置:

优化模型参数

编辑config/config.toml文件中的模型参数:

hljs toml[llm]

# ... 其他设置保持不变

temperature = 0.2 # 降低创造性,提高确定性

max_tokens = 4096 # 增加输出长度上限

添加外部工具支持

OpenManus支持多种外部工具集成。例如,添加网络搜索能力:

- 安装搜索插件:

hljs bashpip install openmanus-plugin-search

- 在配置文件中启用该插件:

hljs toml[plugins]

enabled = ["search"]

使用更强大的商业模型提升效果

如果你希望获得更好的性能,可以配置OpenManus使用商业模型API。这里我们推荐使用laozhang.ai的API服务,它提供了比官方API低至1/4的价格:

- 注册laozhang.ai获取API密钥

- 编辑配置文件:

hljs toml[llm]

model = "gpt-4o-all" # 使用GPT-4o

base_url = "https://api.laozhang.ai/v1"

api_key = "sk-lzapi-xxx" # 替换为你的laozhang.ai API密钥

max_tokens = 4096

temperature = 0.2

省钱提示

使用laozhang.ai API访问顶级商业模型,价格仅为官方的1/4。例如,GPT-4o官方价格$20/百万tokens,而laozhang.ai仅需$5/百万tokens,同时保持100%兼容性和稳定性。

【实战演示】OpenManus能做什么?常见任务实例讲解

现在我们已经成功安装了OpenManus,接下来看看它能完成哪些实际任务。

示例1:市场调研报告生成

输入以下指令:

帮我做一份关于元宇宙行业的市场调研报告,包括市场规模、主要玩家、技术趋势和未来三年的发展预测。

OpenManus会自动:

- 分解任务为多个步骤

- 收集和分析相关数据

- 整理成结构化报告

示例2:代码生成与优化

输入以下指令:

为我创建一个Python爬虫,能够从某电商网站抓取产品信息,包括名称、价格、评分和评论。要求使用异步方式提高效率,并避免被反爬。

OpenManus会:

- 规划爬虫架构

- 生成完整代码

- 添加异步处理和反爬措施

- 提供使用说明

示例3:创意写作辅助

输入以下指令:

我需要写一篇科幻小说,背景设定在2150年的火星殖民地。请帮我构思故事大纲、主要人物设定和关键情节点。

OpenManus会协助你:

- 生成未来火星殖民地的详细背景设定

- 创建有深度的角色档案

- 设计引人入胜的情节结构

- 提供创意写作建议

【常见问题】OpenManus+Ollama使用过程中的疑难解答

使用过程中可能遇到的问题及解决方案:

Q1: OpenManus启动时报错"无法连接到Ollama服务"

解决方案:

- 确认Ollama服务是否正在运行(Windows任务管理器或macOS活动监视器中检查)

- 重启Ollama服务:

hljs bash# Windows: 从开始菜单重启Ollama

# macOS/Linux:

ollama serve

- 检查配置文件中的base_url是否正确(应为http://localhost:11434/api)

Q2: 模型响应速度很慢或不稳定

解决方案:

- 尝试使用更小的模型(如qwen:1.5b或phi:3b)

- 减小config.toml中的max_tokens值

- 如有GPU,确保CUDA正确安装并被识别

- 关闭其他占用大量资源的应用程序

Q3: 安装依赖包时出错

解决方案:

- 更新pip到最新版本:

hljs bashpip install --upgrade pip

- 逐个安装关键依赖:

hljs bashpip install openai pydantic fastapi

- 如果特定包安装失败,可能需要安装操作系统级别的依赖库

Q4: 生成的回答质量不高或不够准确

解决方案:

- 调整模型参数,降低temperature值(0.1-0.3之间)提高确定性

- 尝试使用更高质量的模型(如配置laozhang.ai API使用GPT-4o或Claude 3.5)

- 优化你的提示词,提供更具体的指示和上下文

【总结与展望】OpenManus的价值与未来发展

OpenManus+Ollama的组合为我们提供了一个完全免费且可本地部署的AI智能体解决方案,不仅避免了Manus的邀请码限制和订阅费用,还保护了数据隐私,特别适合个人开发者和小型团队使用。

OpenManus的核心价值

- 经济实惠:使用开源模型完全免费,或通过laozhang.ai API以低成本使用顶级商业模型

- 隐私保护:本地部署,敏感数据不会离开你的设备

- 自由定制:开源架构允许你根据需要扩展和修改功能

- 学习价值:深入了解AI智能体的工作原理和架构设计

未来的发展方向

OpenManus项目正在快速发展中,未来可期的方向包括:

- 支持更多类型的开源模型

- 增强多模态能力(图像、音频处理)

- 改进工具使用的精确度和效率

- 增加更多预设任务模板

- 优化用户界面,提供Web和移动端访问

行动建议

- 现在就开始使用OpenManus+Ollama,体验免费AI智能体的强大功能

- 对于需要更高质量输出的场景,注册laozhang.ai使用低成本的顶级模型API

- 加入OpenManus开源社区,贡献代码或提供反馈

- 尝试结合不同的工具和模型,找到最适合你需求的配置

- 关注项目更新,及时获取新功能和优化

通过本教程,你已经掌握了如何在本地免费部署和使用OpenManus+Ollama,实现了无需邀请码就能体验类似Manus的AI智能体功能。无论你是个人开发者、AI爱好者还是小型团队,这个解决方案都能为你提供可靠、经济且高效的AI助手。

🎯 最后提示:想要更上一层楼?注册laozhang.ai,获取免费额度体验GPT-4o、Claude 3.5等顶级模型,以最低的成本获得最佳的智能体体验!