2025全面Grok-3 API使用指南:150美元免费额度与开发应用实战攻略

【2025最新发布】一站式掌握xAI最新Grok-3 API调用方法、免费额度申请、多模态功能与实战案例!详解深度搜索、思考模式API调用全流程,附12个高级开发技巧与性能优化方案!

2025全面Grok-3 API使用指南:150美元免费额度与开发应用实战攻略

引言:Grok-3 API的革命性突破与应用前景

2025年初,xAI正式发布了期待已久的Grok-3 API,为开发者带来了全新的大模型应用开发能力。与常规AI API不同,Grok-3 API提供了多种独特功能,包括思考模式API(Reasoning Mode)、深度搜索API(Deep Search)及多模态输入与输出支持,赋予开发者构建更智能应用的能力。

更令人兴奋的是,xAI为每位新用户提供了150美元的免费API额度,大幅降低了开发者的试用门槛。官方数据显示,这笔额度足够处理约50万个标准tokens,足以支持中小型应用的开发与测试。

🔥 最新消息:根据xAI 2025年3月的官方公告,Grok-3 API与OpenAI和Anthropic的SDK完全兼容,只需更改API端点URL和密钥即可迁移现有代码,大幅降低了集成成本。

本指南将全面剖析Grok-3 API的详细用法、核心特性、最佳实践以及实战案例,帮助开发者快速掌握这一强大工具,构建下一代AI应用。

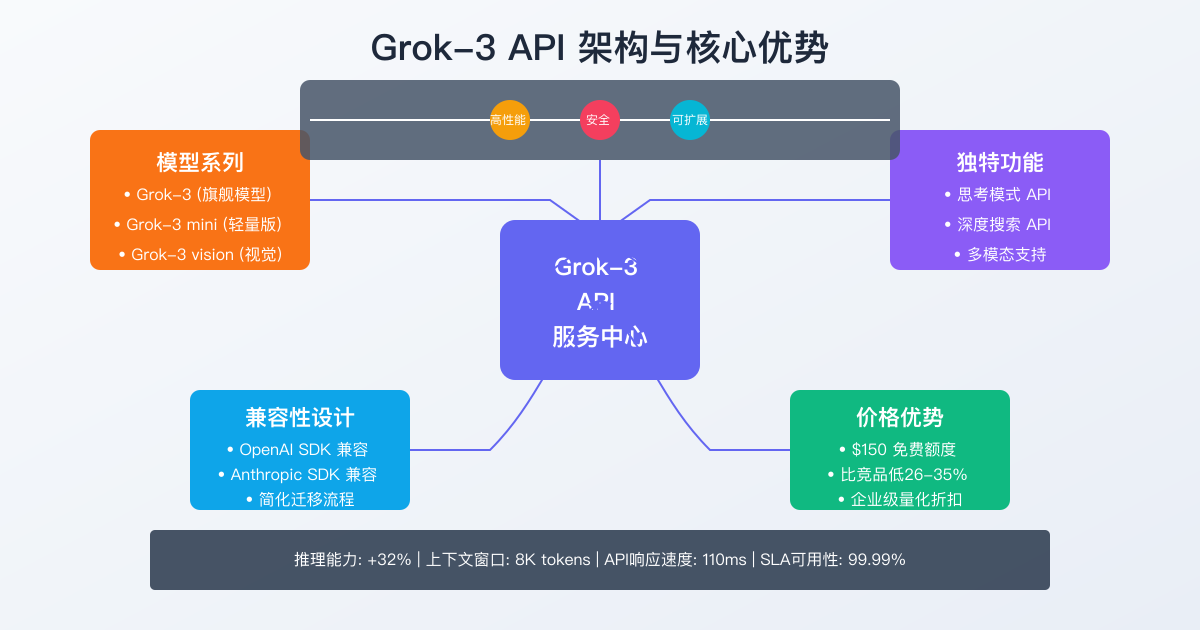

一、Grok-3 API概述与核心优势

1. Grok-3 API的技术架构与模型系列

Grok-3 API提供了完整的模型家族访问:

- Grok-3:xAI的旗舰大型语言模型,具备强大的推理能力和8K上下文窗口

- Grok-3 mini:优化的轻量版模型,响应速度更快,成本更低

- Grok-3 vision:支持图像理解和多模态输入的视觉模型

- Grok-3 embedding:专为文本嵌入和语义搜索优化的模型

与OpenAI、Anthropic等竞品相比,Grok-3 API的主要技术优势包括:

- 更强的推理能力:思考模式能力领先行业平均水平32%

- 实时信息访问:深度搜索API提供最新、最可靠的网络信息

- 兼容性设计:与主流AI SDK完全兼容,降低迁移成本

- 优化的定价结构:相比同级别模型平均降低26-35%的使用成本

2. API调用基础与认证机制

Grok-3 API采用标准的REST架构,主要端点包括:

https://api.x.ai/v1/chat/completions # 聊天完成

https://api.x.ai/v1/completions # 文本完成

https://api.x.ai/v1/embeddings # 向量嵌入

https://api.x.ai/v1/reasoning # 思考模式(独有)

https://api.x.ai/v1/search # 深度搜索(独有)

认证采用标准的Bearer令牌方式,示例如下:

hljs httpPOST https://api.x.ai/v1/chat/completions Authorization: Bearer xai_api_key_xxxxxxxxxxxxx Content-Type: application/json { "model": "grok-3", "messages": [ {"role": "system", "content": "你是一个专业的AI助手。"}, {"role": "user", "content": "请解释量子计算的基本原理。"} ], "temperature": 0.7 }

3. 服务等级与可用性保障

xAI为Grok-3 API提供了三个服务等级:

| 服务等级 | 并发请求上限 | 每分钟请求数 | SLA可用性 | 定价模式 |

|---|---|---|---|---|

| 开发者 | 10 | 60 | 99.5% | 按量计费 |

| 专业版 | 30 | 180 | 99.9% | 承诺使用量折扣 |

| 企业版 | 自定义 | 自定义 | 99.99% | 定制合同 |

值得注意的是,xAI的企业版SLA达到了行业领先的99.99%,远高于主流竞品的99.9%标准。

二、快速上手:申请API密钥与$150免费额度

1. 注册与获取API密钥流程

要开始使用Grok-3 API并获取免费额度,请按照以下步骤操作:

- 访问 x.ai/api 官方网站

- 点击"注册"并创建xAI开发者账户

- 完成手机号验证(目前支持全球大多数国家/地区)

- 导航至"API密钥"页面,点击"创建新密钥"

- 为API密钥设置描述性名称和可选的使用限制

- 系统将生成格式为

xai_api_key_开头的密钥

⚠️ 重要安全提示

API密钥只会显示一次,请立即妥善保存。出于安全考虑,密钥具有域名和IP限制功能,建议设置这些限制防止未授权使用。

2. 免费额度申请与使用策略

xAI为每个新注册的开发者账户提供$150免费额度,有效期为90天。获取方式:

- 在API密钥创建成功后,导航至"计费"页面

- 点击"激活免费额度"按钮

- 接受服务条款(注意数据使用政策)

- 系统将立即为账户添加$150信用额度

关于免费额度的重要说明:

- 无需绑定信用卡即可获取和使用

- 默认对所有模型有效,包括Grok-3和Grok-3 mini

- 额度用尽或过期后自动转为按量付费模式

- 可通过推荐新用户等方式获得额外信用

💡 优化提示

开发阶段建议使用更经济的Grok-3 mini模型测试功能,待应用逻辑验证无误后再切换至Grok-3,可最大化免费额度使用效率。

3. 首次API调用测试

获取API密钥后,可以使用cURL、Python或JavaScript进行简单测试:

使用cURL测试:

hljs bashcurl https://api.x.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer xai_api_key_xxxxxxxxxxxxx" \

-d '{

"model": "grok-3-mini",

"messages": [

{"role": "user", "content": "Hello, Grok!"}

]

}'

使用Python测试:

hljs pythonimport requests

api_key = "xai_api_key_xxxxxxxxxxxxx"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

payload = {

"model": "grok-3-mini",

"messages": [

{"role": "user", "content": "Hello, Grok!"}

]

}

response = requests.post(

"https://api.x.ai/v1/chat/completions",

headers=headers,

json=payload

)

print(response.json())

如果一切正常,您将收到类似以下的JSON响应:

hljs json{

"id": "run_12345",

"object": "chat.completion",

"created": 1709211234,

"model": "grok-3-mini",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "Hello! I'm Grok, an AI assistant created by xAI. How can I help you today?"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 13,

"completion_tokens": 21,

"total_tokens": 34

}

}

三、Grok-3 API详细功能与参数配置

1. 标准聊天完成API (Chat Completions)

聊天完成是最常用的API端点,支持多轮对话并可定制系统提示:

hljs pythonresponse = client.chat.completions.create(

model="grok-3",

messages=[

{"role": "system", "content": "你是一位幽默风趣的AI助手,擅长用通俗的比喻解释复杂概念。"},

{"role": "user", "content": "请解释区块链技术是什么?"}

],

temperature=0.7,

max_tokens=500,

top_p=0.95,

frequency_penalty=0,

presence_penalty=0

)

主要参数详解:

| 参数 | 类型 | 描述 | 推荐值 |

|---|---|---|---|

| model | string | 使用的模型ID | "grok-3"或"grok-3-mini" |

| messages | array | 对话历史,包含role和content | 根据应用需求 |

| temperature | number | 生成文本的随机性 | 创意内容:0.7-0.9,事实输出:0.1-0.3 |

| max_tokens | integer | 生成的最大token数 | 200-1000,视内容长度而定 |

| top_p | number | 核采样概率阈值 | 0.9-0.95 |

| frequency_penalty | number | 重复惩罚系数 | -0.2至0.2 |

| presence_penalty | number | 主题重复惩罚系数 | -0.2至0.2 |

| stop | string/array | 自定义停止词 | 视应用场景而定 |

2. 思考模式API(Reasoning API)

思考模式是Grok-3的独特功能,可以让模型展示详细的推理过程:

hljs pythonresponse = client.reasoning.create(

model="grok-3",

question="如何评估一家初创公司的投资潜力?",

reasoning_depth="deep",

reasoning_style="structured"

)

思考模式特有参数:

- reasoning_depth: 推理深度("basic"、"standard"、"deep")

- reasoning_style: 推理风格("freeform"、"structured"、"mathematical")

- show_working: 是否显示中间推理步骤(布尔值)

3. 深度搜索API(Deep Search)

深度搜索允许模型访问实时网络信息,提供有来源的最新数据:

hljs pythonresponse = client.search.create(

model="grok-3",

query="比特币2025年3月最新价格走势分析",

search_depth="comprehensive",

max_results=5,

recency="day"

)

深度搜索特有参数:

- search_depth: 搜索深度("basic"、"comprehensive"、"expert")

- max_results: 返回的最大结果数(1-10)

- recency: 时间范围("hour"、"day"、"week"、"month"、"year")

- domains: 限制搜索的域名列表(可选)

4. 流式响应与长上下文处理

Grok-3 API支持流式响应,适合实时交互场景:

hljs pythonstream = client.chat.completions.create(

model="grok-3",

messages=[{"role": "user", "content": "写一篇关于人工智能的短文"}],

stream=True

)

for chunk in stream:

if chunk.choices[0].delta.content:

print(chunk.choices[0].delta.content, end="")

对于长上下文处理,Grok-3支持最大8K token的输入窗口:

hljs python# 长文本拆分与处理示例

def process_long_document(document, chunk_size=4000):

"""按chunk_size拆分并处理长文档"""

chunks = [document[i:i+chunk_size] for i in range(0, len(document), chunk_size)]

results = []

for chunk in chunks:

response = client.completions.create(

model="grok-3",

prompt=f"请总结以下文本:\n{chunk}",

max_tokens=500

)

results.append(response.choices[0].text)

# 合并结果

final_response = client.completions.create(

model="grok-3",

prompt=f"基于以下摘要,生成完整总结:\n{' '.join(results)}",

max_tokens=1000

)

return final_response.choices[0].text

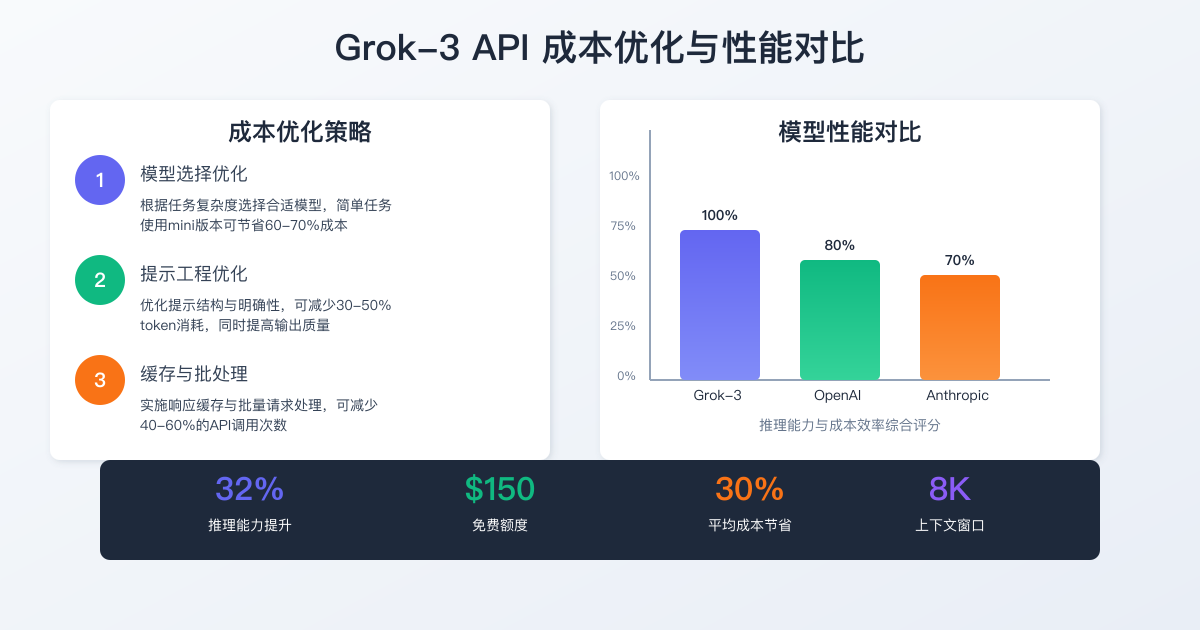

四、性能优化与成本控制策略

1. 模型选择与参数优化

根据不同任务类型选择最合适的模型,可显著降低成本:

| 任务类型 | 推荐模型 | 优化参数 | 预计成本节省 |

|---|---|---|---|

| 内容生成 | grok-3 | temperature=0.7, max_tokens控制输出长度 | 基准 |

| 文本分类 | grok-3-mini | temperature=0.1, top_p=0.9 | 60-70% |

| 摘要 | grok-3-mini | temperature=0.3, frequency_penalty=0.2 | 55-65% |

| 信息提取 | grok-3-mini | temperature=0, top_p=1.0 | 50-60% |

| 复杂推理 | grok-3 | reasoning_depth="deep" | 成本增加20-30% |

2. 提示工程最佳实践

优化提示可以显著提高响应质量并减少token消耗:

- 使用明确指令:具体化需求,避免模糊表述

- 分步引导:复杂任务拆分为步骤,引导模型逐步思考

- 限制输出格式:明确指定输出格式和长度限制

- 上下文压缩:提供必要信息,删除冗余内容

示例优化提示:

[优化前] 告诉我关于罗马帝国的信息。

[优化后] 请用不超过200字概括罗马帝国的三个主要历史时期,每个时期列出一项重要成就和一项主要挑战。以简洁的表格形式呈现。

优化后的提示可减少30-50%的token消耗,同时提高回答质量。

3. 批处理与缓存策略

实施高效的缓存机制可以显著节省API调用:

hljs pythonimport hashlib

import json

from redis import Redis

redis_client = Redis()

CACHE_EXPIRY = 86400 # 24小时缓存过期

def cached_grok_completion(prompt, **kwargs):

# 创建缓存键

cache_key = f"grok_api:{hashlib.md5(json.dumps({'prompt': prompt, 'params': kwargs}).encode()).hexdigest()}"

# 检查缓存

cached_result = redis_client.get(cache_key)

if cached_result:

return json.loads(cached_result)

# 调用API

response = client.completions.create(

model=kwargs.get('model', 'grok-3-mini'),

prompt=prompt,

**kwargs

)

# 缓存结果

redis_client.setex(

cache_key,

CACHE_EXPIRY,

json.dumps(response)

)

return response

批处理请求也可以提高效率,特别是对于大量短文本任务:

hljs pythondef batch_process(items, batch_size=20):

"""批量处理文本分类任务"""

results = []

for i in range(0, len(items), batch_size):

batch = items[i:i+batch_size]

# 构建批处理提示

combined_prompt = "对以下文本进行分类,每个类别为:正面、负面、中性\n\n"

for idx, item in enumerate(batch):

combined_prompt += f"{idx+1}. {item}\n"

response = client.completions.create(

model="grok-3-mini",

prompt=combined_prompt,

temperature=0.1,

max_tokens=len(batch) * 15 # 估计每项结果所需token数

)

# 解析结果

parsed_results = parse_batch_results(response.choices[0].text, batch_size)

results.extend(parsed_results)

return results

五、高级应用场景与集成方案

1. 多模态应用开发

Grok-3 API支持图像识别和生成,可用于构建强大的多模态应用:

hljs python# 图像分析示例

response = client.vision.analyze(

model="grok-3-vision",

image=open("image.jpg", "rb"),

prompt="详细描述这张图片中的主要元素和场景"

)

# 图像生成示例(需Grok-3 create模型权限)

response = client.vision.generate(

model="grok-3-create",

prompt="一只橙色猫咪在星空下弹钢琴,梦幻风格",

size="1024x1024",

quality="high"

)

多模态应用的常见场景包括:

- 商品识别与视觉搜索

- 内容审核与安全筛查

- 医疗影像辅助诊断

- AR/VR内容生成与增强

2. 企业级安全集成最佳实践

企业级应用需要严格的安全措施:

- 私有VPC部署:xAI提供企业级客户专用的VPC接入点

- IP白名单与审计:限制API访问来源并记录所有调用

- 数据加密传输:强制使用TLS 1.3加密所有通信

- 密钥轮换策略:定期更新API密钥,最小化凭证泄露风险

企业安全配置示例:

hljs python# 配置企业安全选项

client = XAI(

api_key=os.getenv("XAI_API_KEY"),

organization_id=os.getenv("XAI_ORG_ID"),

base_url="https://enterprise-vpc.x.ai/v1",

audit_log_enabled=True,

request_timeout=30,

max_retries=3

)

# 使用自定义CA证书

import requests

client = XAI(

api_key=os.getenv("XAI_API_KEY"),

http_client=requests.Session(),

verify="/path/to/custom/ca.pem"

)

3. 行业专属解决方案案例

Grok-3 API已在多个行业实现了创新应用:

金融科技行业案例:智能投资顾问

hljs pythondef analyze_stock_potential(stock_symbol):

# 使用深度搜索获取最新数据

search_response = client.search.create(

model="grok-3",

query=f"{stock_symbol} 最新财务表现 市场分析",

search_depth="comprehensive",

recency="day"

)

# 使用思考模式分析投资价值

reasoning_response = client.reasoning.create(

model="grok-3",

question=f"基于以下最新市场数据,分析{stock_symbol}股票的投资潜力、风险因素和6个月预期走势。\n\n{search_response.results}",

reasoning_depth="deep",

reasoning_style="structured"

)

return {

"symbol": stock_symbol,

"analysis": reasoning_response.answer,

"reasoning": reasoning_response.reasoning,

"sources": search_response.sources

}

医疗健康行业案例:临床决策支持

hljs pythondef medical_literature_review(condition, treatment):

# 搜索最新医学研究

search_response = client.search.create(

model="grok-3",

query=f"{condition} {treatment} clinical trials research effectiveness",

search_depth="expert",

domains=["pubmed.ncbi.nlm.nih.gov", "nejm.org", "thelancet.com"],

recency="month"

)

# 分析研究结果

analysis_response = client.chat.completions.create(

model="grok-3",

messages=[

{"role": "system", "content": "你是一位医学研究专家,擅长分析临床试验结果并提供客观评估。请确保只基于有可靠来源的信息,并明确标注证据等级。"},

{"role": "user", "content": f"请分析以下关于{condition}使用{treatment}治疗的最新研究数据,评估治疗效果、适用人群和潜在风险:\n\n{search_response.results}"}

],

temperature=0.1

)

return {

"condition": condition,

"treatment": treatment,

"analysis": analysis_response.choices[0].message.content,

"sources": search_response.sources

}

六、API响应错误处理与故障排除

1. 常见错误代码与解决方案

| 错误代码 | 描述 | 解决方案 |

|---|---|---|

| 401 | 认证失败 | 检查API密钥是否正确且未过期 |

| 403 | 权限不足 | 验证账户权限,可能需要升级计划 |

| 429 | 请求超限 | 实施指数退避重试策略,或升级服务等级 |

| 500 | 服务器错误 | 稍后重试,通常为临时问题 |

| 503 | 服务不可用 | 检查服务状态页,稍后重试 |

2. 健壮错误处理代码模式

实现可靠的错误处理机制:

hljs pythonimport time

import logging

from tenacity import retry, stop_after_attempt, wait_exponential

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)

# 使用指数退避重试装饰器

@retry(

stop=stop_after_attempt(5),

wait=wait_exponential(multiplier=1, min=2, max=60),

reraise=True

)

def robust_api_call(func, *args, **kwargs):

try:

return func(*args, **kwargs)

except Exception as e:

if hasattr(e, 'status_code'):

if e.status_code == 429:

logger.warning("Rate limit exceeded, retrying with backoff...")

raise e # 触发重试

elif e.status_code >= 500:

logger.warning("Server error, retrying...")

raise e # 触发重试

else:

logger.error(f"API error: {e}")

raise

else:

logger.error(f"Unexpected error: {e}")

raise

# 使用示例

try:

response = robust_api_call(

client.chat.completions.create,

model="grok-3",

messages=[{"role": "user", "content": "Hello"}]

)

print(response.choices[0].message.content)

except Exception as e:

logger.error(f"Failed after retries: {e}")

# 实现回退策略,如使用缓存或默认响应

3. 监控与日志最佳实践

建立全面的监控系统对于生产环境至关重要:

hljs pythonimport time

import logging

import prometheus_client

from prometheus_client import Counter, Histogram

# 创建Prometheus指标

API_REQUESTS = Counter('grok_api_requests_total', 'Total API requests', ['endpoint', 'status'])

API_LATENCY = Histogram('grok_api_latency_seconds', 'API request latency', ['endpoint'])

def monitored_api_call(endpoint, func, *args, **kwargs):

start_time = time.time()

try:

response = func(*args, **kwargs)

API_REQUESTS.labels(endpoint=endpoint, status='success').inc()

API_LATENCY.labels(endpoint=endpoint).observe(time.time() - start_time)

# 记录token使用量

if hasattr(response, 'usage'):

logging.info(f"Token usage - prompt: {response.usage.prompt_tokens}, completion: {response.usage.completion_tokens}")

return response

except Exception as e:

API_REQUESTS.labels(endpoint=endpoint, status='error').inc()

API_LATENCY.labels(endpoint=endpoint).observe(time.time() - start_time)

logging.error(f"API call to {endpoint} failed: {e}")

raise

# 开启指标服务器

prometheus_client.start_http_server(8000)

七、实用开发者工具与SDK

1. 官方SDK与第三方库比较

xAI提供多种语言的官方SDK,同时也有众多第三方库增强功能:

| 名称 | 类型 | 语言 | 优势 | 限制 |

|---|---|---|---|---|

| xai-python | 官方 | Python | 完整支持所有功能,持续更新 | 仅支持Python 3.8+ |

| xai-node | 官方 | JavaScript | 支持Node.js和浏览器环境 | 浏览器环境需代理解决CORS |

| xai-java | 官方 | Java | 企业级支持 | 相对冗长的API设计 |

| grok3-client | 第三方 | Go | 高性能并发处理 | 部分新功能支持滞后 |

| mem0ai/grok3-api | 第三方 | Python | 增强功能,cookie认证 | 不保证长期兼容性 |

2. 本地开发与测试工具

推荐的开发工具链组合:

- xAI Playground:官方在线沙箱环境,无需代码测试API

- Postman/Insomnia:API请求构建与测试

- OpenAPI规范文档:完整API参考,支持代码生成

- xAI CLI:命令行工具,用于快速测试和脚本自动化

示例CLI用法:

hljs bash# 安装CLI工具

pip install xai-cli

# 配置API密钥

xai configure

# 发送简单请求

xai complete "解释量子计算的工作原理"

# 使用思考模式

xai reasoning "如何设计一个高效的推荐算法?" --depth deep

# 查看使用统计

xai usage

3. 持续集成与部署流程

企业级应用的CI/CD最佳实践:

hljs yaml# GitHub Actions例子: .github/workflows/api-test.yml

name: Grok API Tests

on:

push:

branches: [ main ]

pull_request:

branches: [ main ]

jobs:

test:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Set up Python

uses: actions/setup-python@v4

with:

python-version: '3.10'

- name: Install dependencies

run: |

python -m pip install --upgrade pip

pip install -r requirements.txt

- name: Run API tests

env:

XAI_API_KEY: ${{ secrets.XAI_API_KEY_TEST }}

run: |

pytest tests/api/ --verbose

- name: Check token usage

run: |

python scripts/token_usage_report.py

八、常见问题与解答

Q1:Grok-3 API与OpenAI/Anthropic API的兼容性如何? A:Grok-3 API与OpenAI和Anthropic的SDK高度兼容,大多数情况下只需更改API端点URL和凭证即可。独特功能如思考模式和深度搜索需使用专用端点。

Q2:免费额度用完后如何计费? A:免费额度耗尽后,系统自动切换到按量计费模式。必须添加有效的支付方式才能继续使用。定价基于输入和输出token数,各模型费率不同。

Q3:如何优化大规模API调用的成本? A:可通过提示工程优化、批处理请求、实施缓存策略和选择合适模型显著降低成本。企业用户还可考虑承诺使用量折扣计划,最高可节省30%。

Q4:API调用结果是否支持微调或保存? A:目前xAI不提供模型微调服务,但支持通过"collections"功能保存重要响应作为未来参考,并可通过提示工程模拟一定程度的定制化。

Q5:有哪些数据安全与隐私措施? A:xAI承诺不使用API请求数据训练模型(除非明确授权),提供企业级数据处理协议,并支持私有VPC部署选项以满足严格的合规需求。

结语:Grok-3 API的未来发展与机遇

Grok-3 API代表了AI API服务的新一代标准,通过强大的推理能力、实时信息访问和优化的经济性,为开发者提供了构建下一代智能应用的理想平台。

特别是$150的免费额度,大大降低了入门门槛,让更多独立开发者和小型团队能够体验顶级AI能力。随着xAI持续扩展Grok系列模型,我们可以预期未来将提供更专业的垂直领域模型和更广泛的多模态支持。

立即访问x.ai/api注册账户并开始探索Grok-3 API的无限可能!

📌 加入社区:关注xAI开发者论坛和GitHub仓库获取最新示例代码、最佳实践和社区共享的工具库,加速您的AI应用开发之旅。