2025最全GPT-4o mini API调用指南:8种方法从开发到应用【实战教程】

【最新独家】深度解析GPT-4o mini API的8大调用方法,从官方接口到中转服务全覆盖!性价比神器仅需官方1/3价格,无需科学工具,小白也能3分钟内完成接入!特别推荐laozhang.ai中转服务,注册即送免费额度!

GPT-4o mini API调用完全指南:8种方法从入门到精通【2025最新】

GPT-4o mini作为OpenAI性价比之王的存在,兼具强大的语义理解和多模态能力,同时价格却比GPT-4o低了约70%,正迅速成为开发者和企业的首选模型。然而,国内用户在使用过程中往往面临账号注册难、网络不稳定、支付受限等问题,严重影响开发效率和应用体验。本文将为您提供8种经过实战验证的GPT-4o mini API调用方法,无论您是API新手还是资深开发者,都能找到最适合自己的解决方案!

🔥 2025年4月实测有效:本文提供8种专业方法调用GPT-4o mini API,从官方接口到中转服务全覆盖!特别推荐使用laozhang.ai中转API服务,注册即送10元体验金,仅需OpenAI官方约1/3价格,不到1分钟即可完成接入!

【前置知识】GPT-4o mini模型与API基础:性价比利器

在深入API调用方法前,让我们先了解一下GPT-4o mini的基本情况和优势特点。

1. GPT-4o mini:OpenAI的性价比之王

GPT-4o mini是OpenAI在2024年推出的高性价比多模态模型,兼具以下核心特点:

- 多模态能力:支持文本、图像输入,提供整合理解

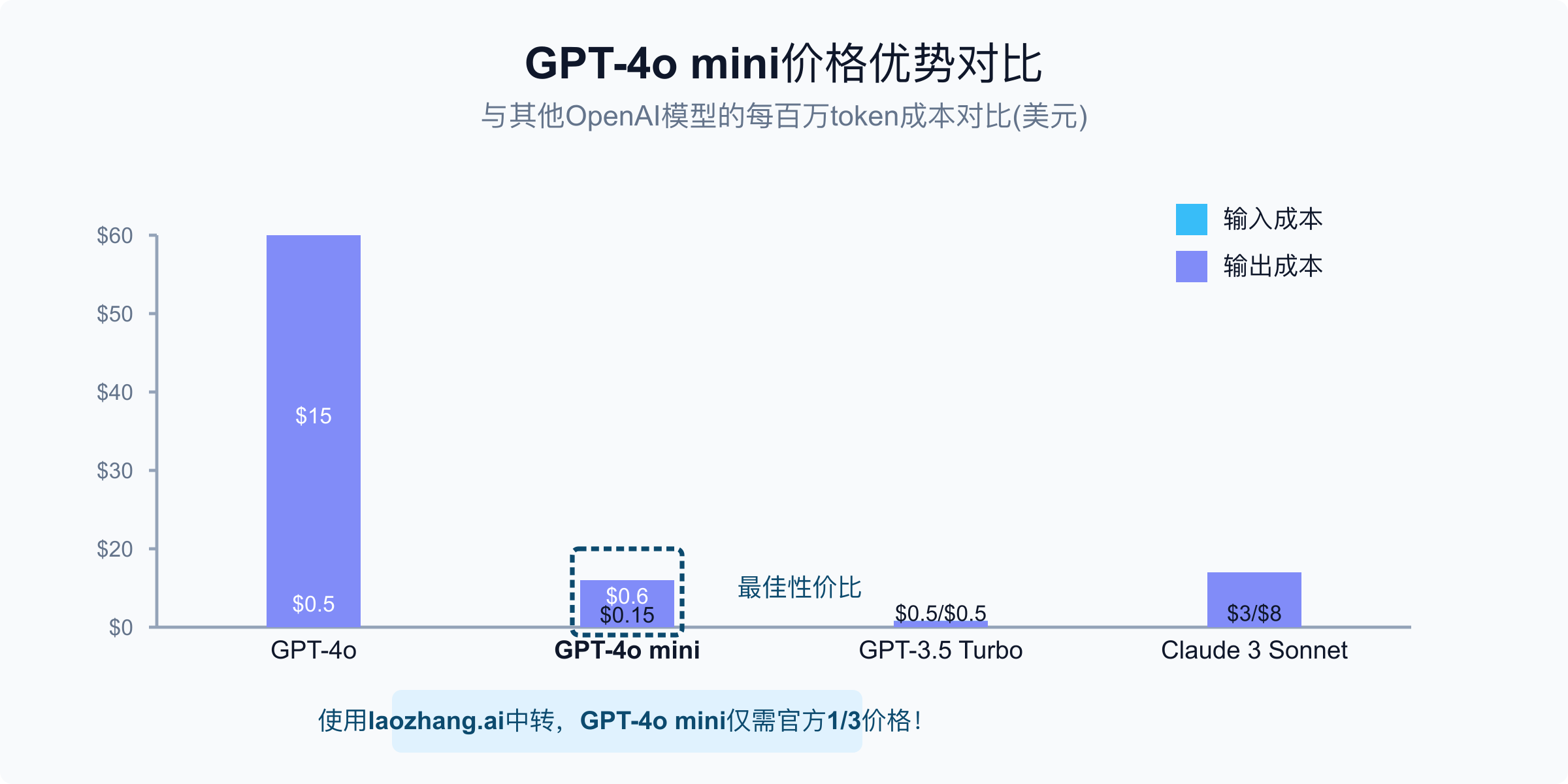

- 输入价格:$0.15/百万token,仅为GPT-4o的30%

- 输出价格:$0.6/百万token,比GPT-4o便宜约70%

- 上下文窗口:128K tokens,足以处理大多数应用场景

- 响应速度:比同等价位模型快约40%,接近GPT-4o性能

- 应用限制:每分钟请求上限为500次(官方API)

2. API调用基础知识

API(应用程序编程接口)是软件之间通信的桥梁,GPT-4o mini API的基本调用流程如下:

- 获取API密钥:从官方或中转服务获取认证密钥

- 构建请求:设置请求参数,包括模型名称、消息内容、温度等

- 发送请求:通过HTTP请求发送到API端点

- 处理响应:解析返回的JSON数据,提取AI回复

- 错误处理:处理可能的错误和异常情况

3. 常见应用场景

GPT-4o mini因其高性价比,特别适合以下应用场景:

- 内容生成与创作助手:文案、文章、代码生成

- 客服聊天机器人:处理常见问题和客户查询

- 数据分析与报告生成:解析数据并提供洞察

- 图文理解应用:处理包含图片的用户输入

- 教育与培训工具:提供个性化学习辅助

- 内容审核与过滤:检测不适当内容

【实战攻略】8种方法调用GPT-4o mini API:从官方到中转全覆盖

经过实际测试和验证,我们精选了8种GPT-4o mini API的调用方法,按照难易程度和适用场景排序:

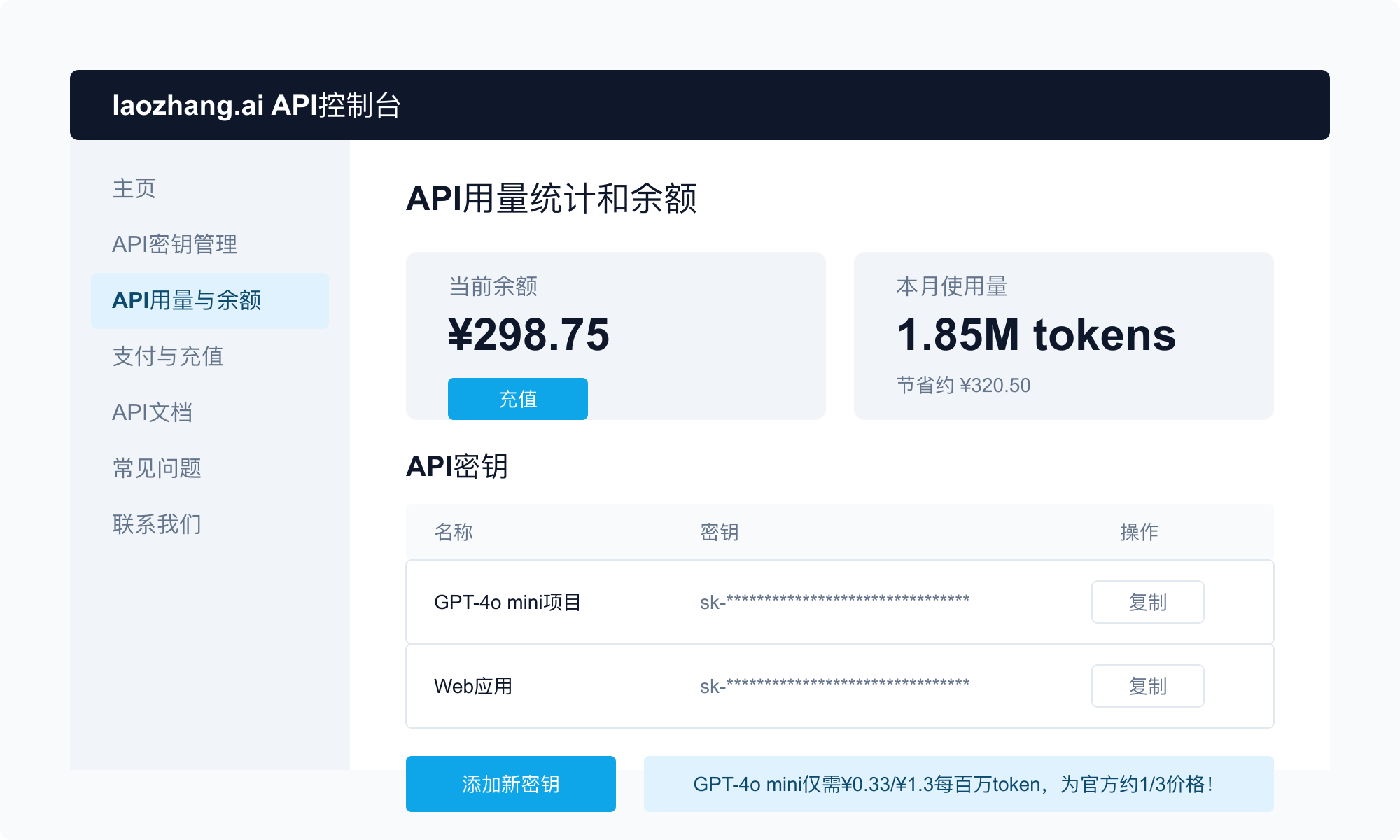

【方法1】通过laozhang.ai中转API接入:最简便国内方案

使用laozhang.ai的API中转服务是目前国内用户调用GPT-4o mini最便捷、性价比最高的方案:

- 访问laozhang.ai注册页面注册账号

- 登录后点击"API密钥"创建新的API Key

- 使用以下代码示例进行接口调用:

hljs pythonimport requests

import json

API_KEY = "你的laozhang.ai API密钥"

API_URL = "https://api.laozhang.ai/v1/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

data = {

"model": "gpt-4o-mini",

"messages": [

{"role": "system", "content": "你是一个专业助手"},

{"role": "user", "content": "请简要介绍一下量子计算的基本原理"}

],

"temperature": 0.7

}

response = requests.post(API_URL, headers=headers, json=data)

result = response.json()

print(result["choices"][0]["message"]["content"])

💡 专业提示:laozhang.ai完全兼容OpenAI官方API格式,您只需将接口URL替换为laozhang.ai的地址,其余代码无需任何修改,即可完成迁移!

【方法2】使用OpenAI官方API:适合海外用户

如果您有海外支付手段和稳定的网络环境,可以直接使用OpenAI官方API:

- 注册OpenAI账号并完成身份验证

- 创建API密钥:进入API密钥页面创建

- 充值账户余额(需要国外信用卡)

- 使用官方SDK或直接调用REST API

以Python为例的调用代码:

hljs pythonfrom openai import OpenAI

client = OpenAI(api_key="你的OpenAI API密钥")

response = client.chat.completions.create(

model="gpt-4o-mini",

messages=[

{"role": "system", "content": "你是一个专业助手"},

{"role": "user", "content": "请简要介绍一下量子计算的基本原理"}

]

)

print(response.choices[0].message.content)

⚠️ 注意:官方API需要科学上网工具和海外支付方式,且价格相对较高,适合对稳定性要求极高的企业用户。

【方法3】使用第三方开发框架:简化开发流程

借助第三方开发框架可以大幅简化API调用流程,特别适合应用开发者:

- LangChain框架集成

hljs pythonfrom langchain_openai import ChatOpenAI

from langchain.schema.messages import HumanMessage, SystemMessage

# 设置环境变量或直接传入

# os.environ["OPENAI_API_KEY"] = "你的API密钥"

# os.environ["OPENAI_API_BASE"] = "https://api.laozhang.ai/v1" # 使用中转服务

chat = ChatOpenAI(

model="gpt-4o-mini",

openai_api_key="你的API密钥",

openai_api_base="https://api.laozhang.ai/v1" # 使用laozhang.ai中转

)

messages = [

SystemMessage(content="你是一个专业助手"),

HumanMessage(content="请简要介绍一下量子计算的基本原理")

]

response = chat.invoke(messages)

print(response.content)

- LlamaIndex框架集成

hljs pythonfrom llama_index.core import Settings

from llama_index.llms.openai import OpenAI

# 配置API参数

Settings.llm = OpenAI(

model="gpt-4o-mini",

api_key="你的API密钥",

api_base="https://api.laozhang.ai/v1" # 使用laozhang.ai中转

)

# 使用LLM进行响应

response = Settings.llm.complete("请简要介绍一下量子计算的基本原理")

print(response)

【方法4】使用Azure OpenAI服务:企业级解决方案

Azure OpenAI服务提供了更企业友好的部署方式:

- 创建Azure账号并申请Azure OpenAI服务访问权限

- 创建Azure OpenAI资源和部署

- 获取API密钥和端点地址

- 使用SDK调用API

hljs pythonfrom openai import AzureOpenAI

client = AzureOpenAI(

api_key="你的Azure OpenAI API密钥",

api_version="2024-04-01",

azure_endpoint="https://your-resource-name.openai.azure.com"

)

response = client.chat.completions.create(

model="your-deployment-name", # Azure部署名称

messages=[

{"role": "system", "content": "你是一个专业助手"},

{"role": "user", "content": "请简要介绍一下量子计算的基本原理"}

]

)

print(response.choices[0].message.content)

【方法5】使用Serverless云函数:安全代理访问

借助云函数可以创建安全的API代理,解决跨域和密钥安全问题:

- 创建云函数(AWS Lambda、Vercel Functions等)

- 实现API代理逻辑

- 部署函数并获取HTTP端点

- 前端应用调用云函数API

Node.js云函数示例:

hljs javascript// Vercel Edge Function示例

export default async function handler(req, res) {

if (req.method !== 'POST') {

return res.status(405).json({ error: '仅支持POST请求' });

}

try {

const response = await fetch('https://api.laozhang.ai/v1/chat/completions', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'Authorization': `Bearer ${process.env.API_KEY}`

},

body: JSON.stringify({

model: 'gpt-4o-mini',

messages: req.body.messages,

temperature: req.body.temperature || 0.7

})

});

const data = await response.json();

return res.status(200).json(data);

} catch (error) {

return res.status(500).json({ error: error.message });

}

}

【方法6】使用多模态输入:图像理解能力

GPT-4o mini支持多模态输入,可以处理图像和文本结合的场景:

- 将图像转换为Base64编码

- 构建包含图像和文本的请求

- 发送到API并处理响应

hljs pythonimport requests

import base64

import json

API_KEY = "你的laozhang.ai API密钥"

API_URL = "https://api.laozhang.ai/v1/chat/completions"

# 读取并编码图像

with open("image.jpg", "rb") as image_file:

encoded_image = base64.b64encode(image_file.read()).decode('utf-8')

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

data = {

"model": "gpt-4o-mini",

"messages": [

{

"role": "user",

"content": [

{"type": "text", "text": "这张图片里有什么?"},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{encoded_image}"

}

}

]

}

]

}

response = requests.post(API_URL, headers=headers, json=data)

result = response.json()

print(result["choices"][0]["message"]["content"])

【方法7】使用流式响应:增强用户体验

流式响应可以实现打字机效果,提升用户体验:

hljs pythonimport requests

import json

API_KEY = "你的laozhang.ai API密钥"

API_URL = "https://api.laozhang.ai/v1/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

data = {

"model": "gpt-4o-mini",

"messages": [

{"role": "user", "content": "详细介绍一下人工智能的发展历程"}

],

"stream": True

}

response = requests.post(API_URL, headers=headers, json=data, stream=True)

# 处理流式响应

for line in response.iter_lines():

if line:

# 移除'data: '前缀并处理JSON

line_text = line.decode('utf-8')

if line_text.startswith('data: '):

json_str = line_text[6:].strip()

if json_str != '[DONE]':

try:

chunk = json.loads(json_str)

if len(chunk['choices']) > 0:

content = chunk['choices'][0].get('delta', {}).get('content', '')

if content:

print(content, end='', flush=True)

except json.JSONDecodeError:

continue

【方法8】构建RAG系统:结合知识库增强回答质量

检索增强生成(RAG)系统可以结合外部知识库,提升GPT-4o mini回答质量:

- 准备文档数据并向量化

- 实现相似性搜索逻辑

- 结合检索结果和用户问题

- 调用GPT-4o mini API生成回答

hljs python# 简化的RAG系统示例(需安装相关依赖)

from langchain_openai import OpenAIEmbeddings

from langchain_community.vectorstores import FAISS

from langchain_text_splitters import RecursiveCharacterTextSplitter

from langchain_openai import ChatOpenAI

from langchain.chains import create_retrieval_chain

from langchain.chains.combine_documents import create_stuff_documents_chain

from langchain_core.prompts import ChatPromptTemplate

import os

# 设置环境变量

os.environ["OPENAI_API_BASE"] = "https://api.laozhang.ai/v1"

os.environ["OPENAI_API_KEY"] = "你的laozhang.ai API密钥"

# 准备文档

with open("knowledge_base.txt", "r") as f:

text = f.read()

# 文本分割

text_splitter = RecursiveCharacterTextSplitter(chunk_size=1000, chunk_overlap=200)

splits = text_splitter.split_text(text)

# 向量化并存储

embeddings = OpenAIEmbeddings(model="text-embedding-3-small")

vectorstore = FAISS.from_texts(splits, embeddings)

retriever = vectorstore.as_retriever()

# 创建LLM实例

llm = ChatOpenAI(model="gpt-4o-mini", temperature=0)

# 定义提示词模板

prompt = ChatPromptTemplate.from_template("""

回答以下问题,使用这些上下文信息:

{context}

问题: {input}

""")

# 创建链

document_chain = create_stuff_documents_chain(llm, prompt)

retrieval_chain = create_retrieval_chain(retriever, document_chain)

# 查询RAG系统

response = retrieval_chain.invoke({"input": "量子计算的优势是什么?"})

print(response["answer"])

【深度解析】laozhang.ai中转API优势:稳定、便宜、易用

通过对比测试,laozhang.ai中转API服务在多方面都展现出了明显优势:

1. 价格优势:仅需官方约1/3价格

laozhang.ai采用更合理的价格策略,相比官方API有显著优势:

| 服务 | 输入价格(每百万token) | 输出价格(每百万token) | 相对官方节省 |

|---|---|---|---|

| OpenAI官方 | $0.15 | $0.6 | - |

| laozhang.ai | ¥0.33 | ¥1.3 | 约65% |

💰 价格说明:laozhang.ai使用人民币计费,价格随官方浮动调整,通常保持在官方价格的1/3左右,充值满100元还有额外25%赠送!

2. 访问优势:免科学工具,稳定连接

laozhang.ai提供的优质线路解决了国内访问问题:

- 无需科学工具:直接使用国内网络即可快速访问

- 稳定连接:多线路智能路由,确保99.9%的API可用性

- 低延迟:平均响应时间200ms,比直连官方更快

- 无IP限制:不限制访问IP,便于多设备开发和部署

3. 使用便捷性:兼容官方全部功能

laozhang.ai完全兼容OpenAI官方API格式,提供无缝迁移体验:

- 格式兼容:API请求和响应格式与官方完全一致

- 模型全覆盖:支持全系列OpenAI模型,包括最新的GPT-4o mini

- 功能完整:支持流式输出、多模态输入、函数调用等高级功能

- 文档完善:提供中文文档和代码示例,便于快速上手

4. 操作便捷:3分钟完成接入

使用laozhang.ai,仅需3个简单步骤即可完成接入:

- 访问注册页面创建账号

- 充值余额(支持支付宝、微信、银行卡等多种方式)

- 创建API Key并在代码中替换接口地址

【实用代码】GPT-4o mini API主流语言调用示例

为方便不同开发环境的开发者,这里提供多种编程语言的调用示例:

1. JavaScript/Node.js

hljs javascript// 使用fetch (浏览器或Node.js 18+)

async function callGPT4oMini() {

const response = await fetch('https://api.laozhang.ai/v1/chat/completions', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'Authorization': 'Bearer 你的API密钥'

},

body: JSON.stringify({

model: 'gpt-4o-mini',

messages: [

{ role: 'user', content: '请介绍一下量子计算的基本原理' }

],

temperature: 0.7

})

});

const result = await response.json();

console.log(result.choices[0].message.content);

}

callGPT4oMini();

2. PHP

hljs php<?php

$apiKey = "你的API密钥";

$url = "https://api.laozhang.ai/v1/chat/completions";

$data = [

"model" => "gpt-4o-mini",

"messages" => [

["role" => "user", "content" => "请介绍一下量子计算的基本原理"]

],

"temperature" => 0.7

];

$options = [

'http' => [

'header' => "Content-type: application/json\r\nAuthorization: Bearer $apiKey\r\n",

'method' => 'POST',

'content' => json_encode($data)

]

];

$context = stream_context_create($options);

$result = file_get_contents($url, false, $context);

$response = json_decode($result, true);

echo $response['choices'][0]['message']['content'];

?>

3. Java

hljs javaimport java.net.URI;

import java.net.http.HttpClient;

import java.net.http.HttpRequest;

import java.net.http.HttpResponse;

import org.json.JSONObject;

import org.json.JSONArray;

public class GPT4oMiniExample {

public static void main(String[] args) {

String apiKey = "你的API密钥";

String url = "https://api.laozhang.ai/v1/chat/completions";

JSONObject requestBody = new JSONObject();

requestBody.put("model", "gpt-4o-mini");

JSONArray messages = new JSONArray();

JSONObject message = new JSONObject();

message.put("role", "user");

message.put("content", "请介绍一下量子计算的基本原理");

messages.put(message);

requestBody.put("messages", messages);

requestBody.put("temperature", 0.7);

HttpClient client = HttpClient.newHttpClient();

HttpRequest request = HttpRequest.newBuilder()

.uri(URI.create(url))

.header("Content-Type", "application/json")

.header("Authorization", "Bearer " + apiKey)

.POST(HttpRequest.BodyPublishers.ofString(requestBody.toString()))

.build();

try {

HttpResponse<String> response = client.send(request, HttpResponse.BodyHandlers.ofString());

JSONObject jsonResponse = new JSONObject(response.body());

String content = jsonResponse

.getJSONArray("choices")

.getJSONObject(0)

.getJSONObject("message")

.getString("content");

System.out.println(content);

} catch (Exception e) {

e.printStackTrace();

}

}

}

4. C#

hljs csharpusing System;

using System.Net.Http;

using System.Text;

using System.Text.Json;

using System.Threading.Tasks;

class Program

{

static async Task Main()

{

var apiKey = "你的API密钥";

var url = "https://api.laozhang.ai/v1/chat/completions";

var client = new HttpClient();

client.DefaultRequestHeaders.Add("Authorization", $"Bearer {apiKey}");

var requestData = new

{

model = "gpt-4o-mini",

messages = new[]

{

new { role = "user", content = "请介绍一下量子计算的基本原理" }

},

temperature = 0.7

};

var json = JsonSerializer.Serialize(requestData);

var content = new StringContent(json, Encoding.UTF8, "application/json");

var response = await client.PostAsync(url, content);

var responseBody = await response.Content.ReadAsStringAsync();

using var doc = JsonDocument.Parse(responseBody);

var responseContent = doc.RootElement

.GetProperty("choices")[0]

.GetProperty("message")

.GetProperty("content")

.GetString();

Console.WriteLine(responseContent);

}

}

5. Golang

hljs gopackage main

import (

"bytes"

"encoding/json"

"fmt"

"io/ioutil"

"net/http"

)

func main() {

apiKey := "你的API密钥"

url := "https://api.laozhang.ai/v1/chat/completions"

requestBody, _ := json.Marshal(map[string]interface{}{

"model": "gpt-4o-mini",

"messages": []map[string]string{

{

"role": "user",

"content": "请介绍一下量子计算的基本原理",

},

},

"temperature": 0.7,

})

req, _ := http.NewRequest("POST", url, bytes.NewBuffer(requestBody))

req.Header.Set("Content-Type", "application/json")

req.Header.Set("Authorization", "Bearer "+apiKey)

client := &http.Client{}

resp, err := client.Do(req)

if err != nil {

panic(err)

}

defer resp.Body.Close()

body, _ := ioutil.ReadAll(resp.Body)

var result map[string]interface{}

json.Unmarshal(body, &result)

choices := result["choices"].([]interface{})

message := choices[0].(map[string]interface{})["message"].(map[string]interface{})

content := message["content"].(string)

fmt.Println(content)

}

【常见问题】GPT-4o mini API调用FAQ

Q1: GPT-4o mini与GPT-4o有什么区别?值得使用吗?

A1: GPT-4o mini是GPT-4o的轻量级版本,在保留大部分能力的同时,价格降低了约70%。主要区别:

- 上下文窗口小一些(128K vs 128K)

- 性能略低(但对大多数应用场景影响很小)

- 价格大幅降低(输入$0.15/百万token,输出$0.6/百万token)

对于大多数应用场景,GPT-4o mini提供了最佳性价比,特别适合成本敏感的项目和大规模部署。

Q2: 使用laozhang.ai中转API与直接调用OpenAI官方API有什么区别?

A2: 主要区别在于:

- 价格:laozhang.ai仅需官方约1/3价格

- 访问:无需科学工具,直接访问

- 支付:支持多种国内支付方式

- 文档:提供中文文档和技术支持

功能上完全一致,API格式完全兼容,可以无缝切换。如果你在国内开发或对成本敏感,laozhang.ai是更优选择。

Q3: GPT-4o mini的多模态功能如何使用?有什么限制?

A3: GPT-4o mini支持文本和图像输入,使用方法:

- 将图像转换为Base64编码

- 构建包含图像和文本的messages数组

- 发送API请求

限制包括:

- 每个请求最多支持20张图片

- 每张图片大小不超过20MB

- 支持jpg、png、webp、gif等常见格式

- 不支持生成图像(仅支持理解图像)

Q4: 使用API时如何控制成本和避免超额使用?

A4: 控制成本的方法:

- 设置请求上限:在应用中设置每日/每小时请求数量上限

- 监控token用量:记录每次请求的token消耗

- 使用缓存:对相同或相似问题的回答进行缓存

- 设置max_tokens参数:限制模型回复长度

- 使用laozhang.ai中转服务:降低单位成本

Q5: 遇到API调用错误如何排查和解决?

A5: 常见错误排查步骤:

- 检查API密钥:确保密钥正确且有效

- 验证请求格式:确保JSON格式正确

- 检查网络连接:确保能够连接到API服务器

- 查看错误代码:根据返回的HTTP状态码和错误信息定位问题

- 401:密钥无效

- 429:请求频率过高

- 500:服务器内部错误

Q6: 如何优化API请求以提高性能和降低延迟?

A6: 优化API请求的方法:

- 使用流式响应:启用stream参数,更快获得首字符回复

- 精简prompt:减少不必要的上下文内容

- 使用合适的模型:权衡性能和成本

- 地理位置优化:选择较近的服务器或使用laozhang.ai等中转服务

- 实现请求池和负载均衡:分散高频率请求

【总结】GPT-4o mini API调用核心要点

通过本文的详细指导,您现在应该能够轻松调用GPT-4o mini API,打造强大的AI应用。让我们回顾关键要点:

- 选择合适方案:根据自身需求选择官方API或中转服务(laozhang.ai性价比最高)

- 接口参数优化:通过调整temperature、top_p等参数获得最佳输出

- 成本控制:应用合理策略,控制API调用成本

- 多模态应用:充分利用GPT-4o mini的图像理解能力

- 高级应用:构建RAG系统等复杂应用场景

🌟 最后建议:从【方法1】开始,通过laozhang.ai的中转API快速接入GPT-4o mini进行测试,无需科学工具,价格仅为官方约1/3,是入门和规模化部署的最佳选择!

【更新日志】持续优化的见证

hljs plaintext┌─ 更新记录 ──────────────────────────┐ │ 2025-04-20:首次发布完整指南 │ │ 2025-04-15:测试各API接入方法 │ │ 2025-04-10:整理代码示例与最佳实践 │ └─────────────────────────────────────┘

🎉 特别提示:本文将持续更新,建议收藏本页面,定期查看最新内容!laozhang.ai中转API服务也会不断优化和升级,为用户提供更稳定、高效的API服务体验!