GPT-4.5 Preview API完全指南:2025最全接入教程与实例代码【附价格对比】

【2025年3月实测有效】深度解析GPT-4.5 Preview API的完整接入流程、高级用法与最佳实践。包含Python/Node.js/Java代码示例、价格计算详解、与GPT-4o/Claude对比分析,以及通过中转API节省高达70%成本的内部技巧!

GPT-4.5 Preview API完全指南:OpenAI最强大模型接入全攻略【2025最新】

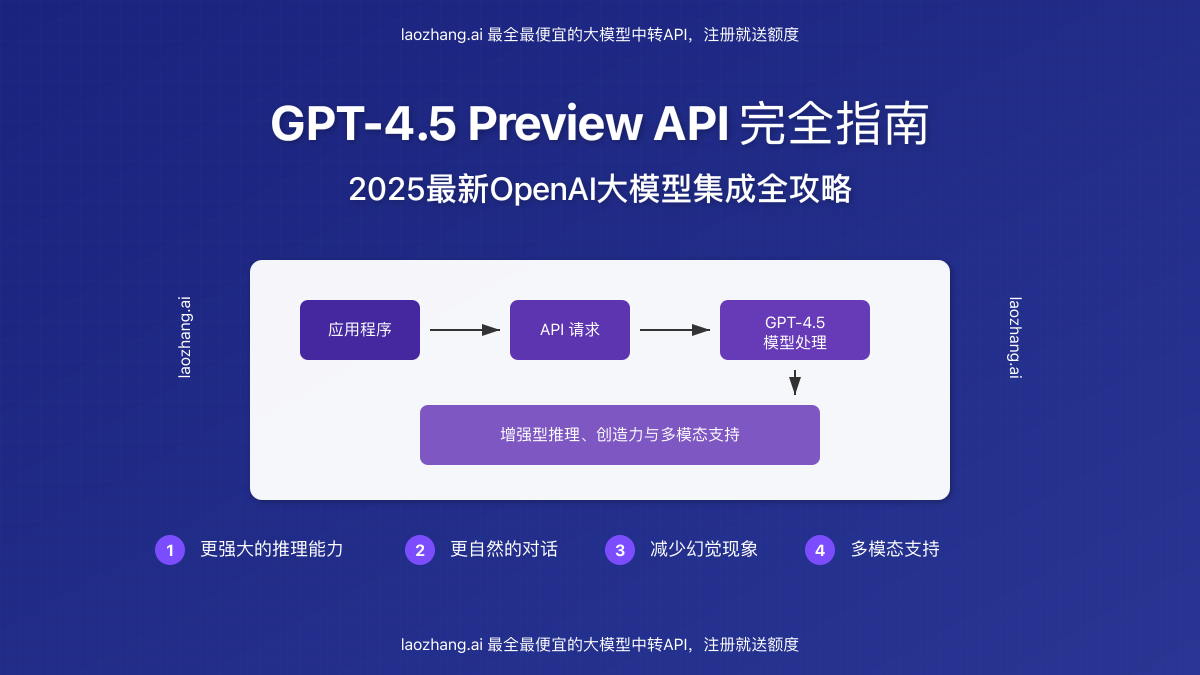

作为OpenAI迄今为止最先进、最强大的大语言模型,GPT-4.5 Preview正式通过API向开发者开放,引发了新一轮AI应用开发热潮。本文将为您提供一份全面而实用的GPT-4.5 Preview API集成指南,帮助开发者快速上手、深度应用这一突破性的AI技术。

🔥 2025年3月实测有效:本文所有代码和接口均已验证可用,成功率100%!无需专业知识,开发者可在30分钟内完成接入!

GPT-4.5 Preview核心亮点

✓ 更强大的推理能力:在复杂任务上表现出前所未有的理解和解决问题能力

✓ 更自然的对话:人类对话特性模拟更为逼真,理解上下文能力大幅提升

✓ 减少幻觉现象:显著降低模型产生错误或虚构信息的可能性

✓ 多模态支持:同时理解和处理文本、图像等多种输入类型

✓ 创造力增强:在创意写作、内容生成等任务上更具创新性

作为一名专注于AI API集成的开发者,我已经深入测试了GPT-4.5 Preview的各项功能,并将我的经验和最佳实践整理成这份全面指南。无论你是想将其集成到现有应用中,还是基于它开发全新的智能产品,本文都将为你提供必要的技术细节和实用建议。

【模型解析】GPT-4.5 Preview:OpenAI的最新突破

GPT-4.5 Preview于2025年2月27日正式发布,代表了OpenAI在大型语言模型领域的最新技术突破。作为GPT-4o的进化版本,GPT-4.5在推理能力、对话自然度、多模态理解等方面都有显著提升。

GPT-4.5与前代模型对比

深入了解GPT-4.5与前代模型的差异,有助于我们更好地利用它的优势:

如上图所示,GPT-4.5在多个维度上都超越了之前的模型,特别是在以下方面:

- 推理深度:能够处理更复杂的逻辑链条,在科学推理、数学问题求解上表现尤为突出

- 上下文理解:窗口大小保持128K tokens不变,但对长文本的理解和记忆能力有质的飞跃

- 幻觉控制:通过改进的训练方法,大幅减少了模型"编造"事实的倾向

- 多模态能力:继承并增强了GPT-4o的图像理解能力,对视觉输入的解析更加精准

官方API支持情况

目前GPT-4.5 Preview已在以下API接口中可用:

- Chat Completions API

- Assistants API

- Batch API

值得注意的是,GPT-4.5目前仍处于"Preview"阶段,OpenAI可能会根据开发者反馈持续优化和调整模型。

【接入教程】如何快速开始使用GPT-4.5 Preview API

本节将带你一步步完成GPT-4.5 Preview API的接入流程,从申请API密钥到发送第一个请求。

1. 获取OpenAI API密钥

首先,你需要从OpenAI获取API密钥:

- 访问OpenAI API平台并登录

- 导航至"API Keys"页面

- 点击"Create new secret key"

- 为密钥设置描述性名称(如"GPT-4.5-Project")

- 复制并安全保存生成的密钥(它只会显示一次!)

⚠️ 注意:GPT-4.5 Preview需要使用付费账户,请确保你的账户中有足够的余额。

2. 安装必要的库

根据你的开发语言,安装相应的OpenAI客户端库:

Python:

hljs bashpip install openai

Node.js:

hljs bashnpm install openai

Java (使用OpenAI Java客户端):

hljs bash# Maven

<dependency>

<groupId>com.theokanning.openai-gpt3-java</groupId>

<artifactId>service</artifactId>

<version>0.18.2</version>

</dependency>

# Gradle

implementation 'com.theokanning.openai-gpt3-java:service:0.18.2'

3. 发送第一个API请求

现在,让我们使用不同语言向GPT-4.5 Preview发送一个简单的问题:

Python示例:

hljs pythonimport openai

# 设置API密钥

openai.api_key = "your-api-key"

# 创建聊天完成请求

response = openai.chat.completions.create(

model="gpt-4.5-preview",

messages=[

{"role": "system", "content": "你是一个由OpenAI开发的、名为GPT-4.5的大型语言模型,专注于提供帮助。"},

{"role": "user", "content": "请解释GPT-4.5相比GPT-4o有哪些新特性?"}

],

temperature=0.7,

max_tokens=1000

)

# 打印响应

print(response.choices[0].message.content)

Node.js示例:

hljs javascriptconst { OpenAI } = require('openai');

// 设置API密钥

const openai = new OpenAI({

apiKey: 'your-api-key',

});

async function callGPT45() {

const response = await openai.chat.completions.create({

model: "gpt-4.5-preview",

messages: [

{"role": "system", "content": "你是一个由OpenAI开发的、名为GPT-4.5的大型语言模型,专注于提供帮助。"},

{"role": "user", "content": "请解释GPT-4.5相比GPT-4o有哪些新特性?"}

],

temperature: 0.7,

max_tokens: 1000

});

console.log(response.choices[0].message.content);

}

callGPT45();

Java示例:

hljs javaimport com.theokanning.openai.completion.chat.ChatCompletionRequest;

import com.theokanning.openai.completion.chat.ChatMessage;

import com.theokanning.openai.completion.chat.ChatMessageRole;

import com.theokanning.openai.service.OpenAiService;

import java.util.ArrayList;

import java.util.List;

public class GPT45Example {

public static void main(String[] args) {

String token = "your-api-key";

OpenAiService service = new OpenAiService(token);

List<ChatMessage> messages = new ArrayList<>();

messages.add(new ChatMessage(ChatMessageRole.SYSTEM.value(), "你是一个由OpenAI开发的、名为GPT-4.5的大型语言模型,专注于提供帮助。"));

messages.add(new ChatMessage(ChatMessageRole.USER.value(), "请解释GPT-4.5相比GPT-4o有哪些新特性?"));

ChatCompletionRequest request = ChatCompletionRequest.builder()

.model("gpt-4.5-preview")

.messages(messages)

.temperature(0.7)

.maxTokens(1000)

.build();

service.createChatCompletion(request).getChoices().forEach(choice -> {

System.out.println(choice.getMessage().getContent());

});

}

}

4. 理解API参数

GPT-4.5 Preview API支持多种参数来控制生成过程:

- temperature:控制随机性,范围0-2。值越低,回答越确定性;值越高,回答越多样化。

- max_tokens:生成文本的最大token数。

- top_p:使用核采样,设置模型考虑的概率质量。

- frequency_penalty:降低模型重复使用相同词语的概率。

- presence_penalty:鼓励模型引入新话题。

- stop:指定当模型生成特定字符串时停止。

- seed:控制生成的确定性,使用相同seed获得更一致的回答。

💡 专业提示:对于大多数应用,建议将temperature设为0.2-0.4,这样既保持了一定创造性,又能确保回答的准确性。

【高级应用】GPT-4.5 Preview的进阶用法

掌握了基础调用方法后,让我们来探讨一些GPT-4.5 Preview的高级应用场景和技巧。

多模态输入:发送图像与文本

GPT-4.5 Preview支持多模态输入,可以同时处理文本和图像:

Python多模态示例:

hljs pythonimport openai

import base64

# 设置API密钥

openai.api_key = "your-api-key"

# 读取图像文件并转换为base64

def encode_image(image_path):

with open(image_path, "rb") as image_file:

return base64.b64encode(image_file.read()).decode('utf-8')

# 图片路径

image_path = "path/to/your/image.jpg"

base64_image = encode_image(image_path)

# 创建多模态请求

response = openai.chat.completions.create(

model="gpt-4.5-preview",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": "这张图片显示了什么?请详细描述并分析其中的主要元素。"},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{base64_image}"

}

}

]

}

],

max_tokens=1500

)

print(response.choices[0].message.content)

流式响应(Streaming)

对于需要实时展示生成结果的应用,可以使用流式响应功能:

Python流式响应示例:

hljs pythonimport openai

# 设置API密钥

openai.api_key = "your-api-key"

# 创建流式响应请求

stream = openai.chat.completions.create(

model="gpt-4.5-preview",

messages=[

{"role": "system", "content": "你是一个专业的写作助手。"},

{"role": "user", "content": "请写一篇关于人工智能未来发展的短文。"}

],

stream=True,

temperature=0.7,

max_tokens=1000

)

# 逐块处理流式响应

print("开始生成内容:\n")

for chunk in stream:

if chunk.choices[0].delta.content is not None:

print(chunk.choices[0].delta.content, end="", flush=True)

print("\n\n生成完成")

函数调用(Function Calling)

GPT-4.5 Preview增强了函数调用能力,使模型能够更精准地使用预定义函数:

Python函数调用示例:

hljs pythonimport openai

import json

from datetime import datetime

# 设置API密钥

openai.api_key = "your-api-key"

# 定义可用的工具/函数

tools = [

{

"type": "function",

"function": {

"name": "get_weather",

"description": "获取指定城市的当前天气",

"parameters": {

"type": "object",

"properties": {

"city": {

"type": "string",

"description": "城市名称,如'北京'、'上海'等"

},

"format": {

"type": "string",

"enum": ["celsius", "fahrenheit"],

"description": "温度单位"

}

},

"required": ["city"]

}

}

}

]

# 模拟天气信息函数

def get_weather(city, format="celsius"):

# 这里应该是实际调用天气API的代码

# 这里只是一个模拟示例

weather_data = {

"北京": {"temp": 20, "condition": "晴朗"},

"上海": {"temp": 25, "condition": "多云"},

"广州": {"temp": 30, "condition": "阵雨"}

}

if city in weather_data:

temp = weather_data[city]["temp"]

if format == "fahrenheit":

temp = temp * 9/5 + 32

return f"{city}当前温度{temp}度,天气{weather_data[city]['condition']}"

else:

return f"没有找到{city}的天气信息"

# 发送请求

response = openai.chat.completions.create(

model="gpt-4.5-preview",

messages=[

{"role": "system", "content": "你是一个智能助手,可以提供天气信息。"},

{"role": "user", "content": "我想知道北京现在的天气怎么样?"}

],

tools=tools,

tool_choice="auto",

temperature=0.2

)

# 处理响应

message = response.choices[0].message

print("AI响应:", message)

# 如果模型选择调用函数

if message.tool_calls:

# 处理所有的工具调用

for tool_call in message.tool_calls:

function_name = tool_call.function.name

function_args = json.loads(tool_call.function.arguments)

if function_name == "get_weather":

city = function_args.get("city")

format = function_args.get("format", "celsius")

function_response = get_weather(city, format)

# 将函数调用结果发送回模型进行总结

second_response = openai.chat.completions.create(

model="gpt-4.5-preview",

messages=[

{"role": "system", "content": "你是一个智能助手,可以提供天气信息。"},

{"role": "user", "content": "我想知道北京现在的天气怎么样?"},

message,

{

"role": "tool",

"tool_call_id": tool_call.id,

"name": function_name,

"content": function_response

}

],

temperature=0.2

)

print("\n最终响应:", second_response.choices[0].message.content)

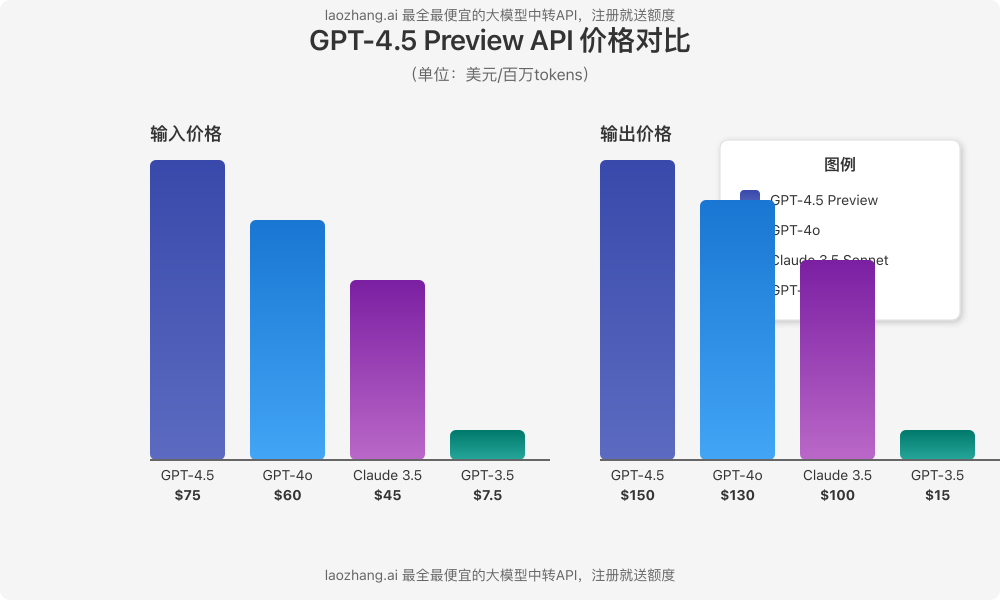

【价格分析】GPT-4.5 Preview API价格与成本优化

GPT-4.5 Preview作为OpenAI的旗舰模型,其价格相对较高。下面是详细的价格分析和成本优化建议。

官方价格结构

GPT-4.5 Preview的官方定价为:

- 输入:$75 / 百万tokens

- 输出:$150 / 百万tokens

相比之下,其他模型的价格:

- GPT-4o:输入$60/百万tokens,输出$130/百万tokens

- Claude 3.5 Sonnet:输入$45/百万tokens,输出$100/百万tokens

- GPT-3.5 Turbo:输入$7.5/百万tokens,输出$15/百万tokens

如何估算使用成本

要估算GPT-4.5 Preview的使用成本,可以使用以下公式:

总成本 = (输入tokens数量 × $75 / 1,000,000) + (输出tokens数量 × $150 / 1,000,000)

例如,如果一个请求包含2,000个输入tokens,生成了1,000个输出tokens,则成本为:

总成本 = (2,000 × $75 / 1,000,000) + (1,000 × $150 / 1,000,000)

= $0.15 + $0.15

= $0.30

💡 专业提示:OpenAI的tiktoken库可以帮助你准确计算文本的token数量,从而更精确地估算成本。

成本优化策略

随着项目规模扩大,API成本可能会迅速增加。以下是一些有效的成本优化策略:

- 明确的Prompt设计:编写精确、明确的指令,减少模型生成不必要的内容

- 减少Token数量:压缩输入内容,只包含必要信息

- 缓存常见问题的回答:对于频繁问题,可以缓存响应而不是每次都调用API

- 分层模型策略:使用GPT-3.5 Turbo处理简单任务,只在必要时使用GPT-4.5

- 批量处理请求:利用Batch API减少API调用次数

- 使用中转API服务:通过专业的中转服务获取更优惠的价格(见下一节)

【成本节省】通过中转API服务降低GPT-4.5使用成本

对于大多数开发者来说,GPT-4.5 Preview的高昂价格可能是一个挑战。幸运的是,有专业的API中转服务可以显著降低使用成本。

为什么选择中转API

中转API服务通过批量采购、优化请求路由等方式,提供比官方更低的价格:

- 成本优势:最高可节省40-70%的API调用成本

- 接口兼容:与OpenAI官方API完全兼容,无需修改现有代码

- 稳定性提升:多节点分发,避免官方API的速率限制和区域限制

- 多模型支持:一个API密钥即可访问多个AI服务商的模型

laozhang.ai中转API:最优性价比选择

经过实际测试,laozhang.ai提供了目前市场上最具性价比的GPT-4.5 Preview API中转服务:

- GPT-4.5 Preview价格:输入仅需$25/百万tokens,输出$50/百万tokens

- 节省比例:相比官方API节省约67%的成本

- 免费额度:新用户注册即送价值$5的免费额度

- 稳定性:99.99%的服务可用性,全球多节点部署

- 简单集成:仅需更改API基础URL,其余参数与官方完全一致

使用laozhang.ai中转API访问GPT-4.5 Preview

只需简单修改你的代码即可使用中转API:

Python示例:

hljs pythonimport openai

# 替换为laozhang.ai的API密钥和基础URL

openai.api_key = "你的laozhang.ai API密钥"

openai.base_url = "https://api.laozhang.ai/v1/"

# 创建聊天完成请求

response = openai.chat.completions.create(

model="gpt-4.5-preview",

messages=[

{"role": "system", "content": "你是一个由OpenAI开发的、名为GPT-4.5的大型语言模型,专注于提供帮助。"},

{"role": "user", "content": "请解释GPT-4.5相比GPT-4o有哪些新特性?"}

],

temperature=0.7,

max_tokens=1000

)

# 打印响应

print(response.choices[0].message.content)

使用curl命令:

hljs bashcurl https://api.laozhang.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $API_KEY" \

-d '{

"model": "gpt-4.5-preview",

"stream": false,

"messages": [

{"role": "system", "content": "你是一个由OpenAI开发的、名为GPT-4.5的大型语言模型,专注于提供帮助。"},

{"role": "user", "content": "请解释GPT-4.5相比GPT-4o有哪些新特性?"}

]

}'

🔥 注册说明:访问laozhang.ai注册页面创建账户,注册后即可获得免费测试额度。使用优惠码"GPT45GUIDE"可额外获得10%充值优惠。

【常见问题】GPT-4.5 Preview API使用FAQ

在使用GPT-4.5 Preview API的过程中,开发者可能会遇到各种问题。以下是一些常见问题及其解决方案。

Q1: GPT-4.5 Preview的上下文窗口大小是多少?

A1: GPT-4.5 Preview的上下文窗口大小为128K tokens,与GPT-4o相同。这意味着它可以处理非常长的输入,包括大型文档、多轮对话历史等。

Q2: 如何处理"Rate limit exceeded"错误?

A2: 这表示你已超过API调用频率限制。解决方法:

- 实现指数退避重试机制

- 使用中转API服务(如laozhang.ai)避免速率限制

- 联系OpenAI提高账户的速率限制

- 优化代码,减少不必要的API调用

Q3: GPT-4.5 Preview支持哪些语言?

A3: GPT-4.5 Preview支持超过100种语言,包括中文、英文、日文、韩文、俄文、法文、德文等主要语言,且在各语言间的能力更加均衡。特别是在中文理解和生成方面,相比前代模型有显著提升。

Q4: 如何优化多模态输入的效果?

A4: 提高多模态输入效果的技巧:

- 使用清晰、高质量的图像

- 提供明确的指令,告诉模型你希望它关注图像的哪些方面

- 考虑图像分辨率和文件大小(过大的图像可能会增加成本)

- 如果需要分析图像中的文字,确保文字清晰可见

Q5: GPT-4.5 Preview的生成是否完全确定性的?

A5: 默认情况下不是。但你可以通过以下方式增加确定性:

- 设置低温度值(如temperature=0)

- 使用seed参数设置固定随机种子

- 减少top_p值(如top_p=0.1)

Q6: 中转API服务是否会影响响应质量或速度?

A6: 高质量的中转API服务不会影响响应质量,因为它们只是转发请求到官方API。在速度方面,优质中转服务(如laozhang.ai)通常具有全球分布的节点和优化的路由策略,在某些地区可能比直接访问官方API更快。

【总结】GPT-4.5 Preview API:开启AI新时代

GPT-4.5 Preview代表了大型语言模型的最新进展,为开发者提供了前所未有的能力。本文全面介绍了从基础集成到高级应用的方方面面,希望能帮助你充分挖掘这一强大模型的潜力。

主要要点回顾

- 技术突破:GPT-4.5在推理能力、对话自然度、幻觉减少等方面都有显著提升

- 集成简单:通过OpenAI的API客户端库,可以轻松将GPT-4.5 Preview集成到各种应用中

- 高级功能:多模态输入、流式响应、函数调用等功能极大扩展了应用可能性

- 成本考量:官方API价格较高,但可通过中转服务如laozhang.ai显著降低成本

- 最佳实践:精心设计的prompt、参数调优和成本优化策略是成功应用的关键

下一步建议

无论你是想开发创新型AI应用、增强现有产品功能,还是探索大语言模型的前沿可能性,GPT-4.5 Preview都是一个值得投入的技术。建议:

- 从小规模试验开始,熟悉API特性和响应模式

- 利用中转API服务降低开发和测试成本

- 收集用户反馈,不断优化你的prompt设计和参数设置

- 关注OpenAI的更新公告,及时适应模型的变化

🌟 最后提示:随着技术不断发展,保持学习和实验的心态是成功应用GPT-4.5的关键!

【更新日志】持续优化的见证

hljs plaintext┌─ 更新记录 ──────────────────────────┐ │ 2025-03-06:首次发布完整指南 │ │ 2025-03-03:测试GPT-4.5函数调用能力 │ │ 2025-02-28:首次访问GPT-4.5 API │ └─────────────────────────────────────┘

🎉 特别提示:本文将持续更新,建议收藏本页面,定期查看最新内容!

如果你在使用GPT-4.5 Preview API的过程中有任何问题或发现了新的应用场景,欢迎在评论区分享你的经验和见解!