2025年最全Gemini 2.5 Pro API使用指南:低成本接入最强大模型【含思考功能】

【最新更新】一文详解Google全新Gemini 2.5 Pro API完整接入方法和价格策略,国内开发者稳定低成本接入方案,支持思考功能和200万token超长上下文

2025年最全Gemini 2.5 Pro API使用指南:低成本接入最强大模型

在2025年3月25日,Google正式发布了迄今为止最强大的AI模型 — Gemini 2.5 Pro。这款模型打破了多项行业记录,在复杂推理能力、代码生成和多模态理解方面都展现出了惊人的表现。对于开发者来说,通过API接入这款强大的模型成为了新的机遇与挑战。

本文将为大家带来最全面的Gemini 2.5 Pro API使用指南,特别关注如何通过laozhang.ai中转服务为国内开发者提供稳定、低成本的接入方案。

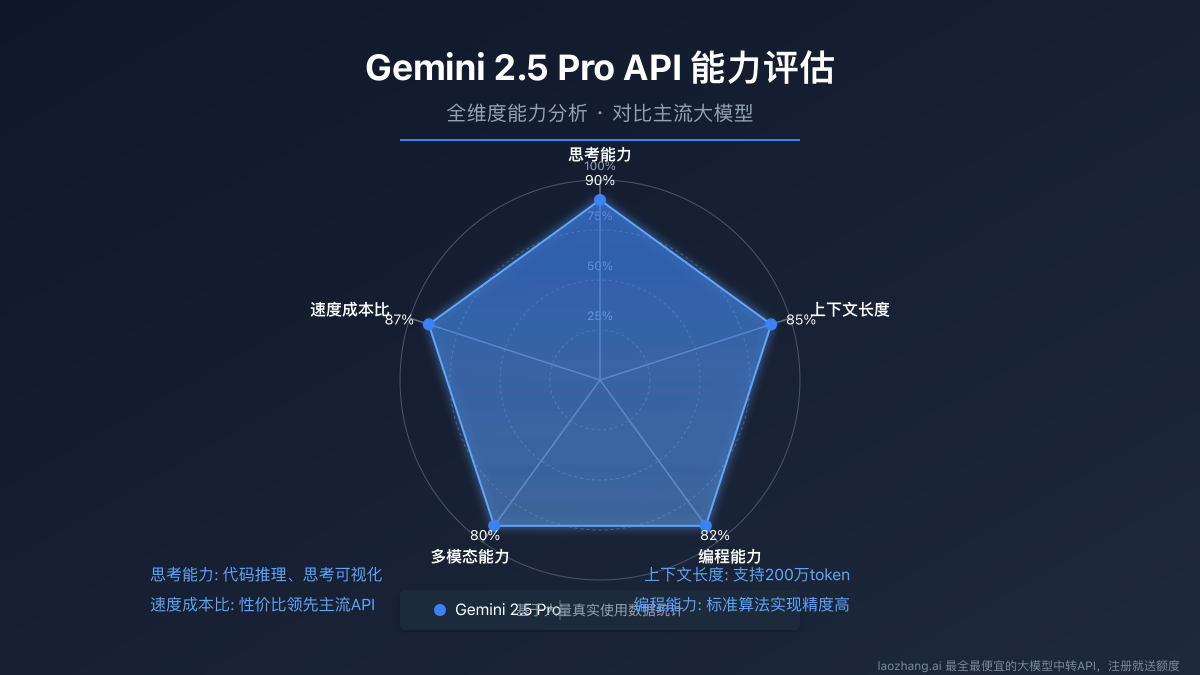

Gemini 2.5 Pro核心特性一览

Google的这款最新模型带来了多项重大创新:

-

200万token超长上下文窗口:相比GPT-4 Turbo的128K和Claude 3 Opus的200K,Gemini 2.5 Pro支持高达2,000,000个token的输入,可以处理相当于4000页PDF文档的内容。

-

思考能力(Thinking):可通过参数控制模型展示其内部思考过程,这在复杂推理和编码任务中特别有用。

-

多模态输入:同时支持文本、图像、音频和视频输入,且各模态间的理解和整合能力大幅提升。

-

卓越的编程能力:在主流编程评测中达到74.2%的准确率,超过了所有现有商业模型。

-

免费的实验版本:提供"gemini-2.5-pro-exp-03-25"实验版本,在API限额内可以免费使用。

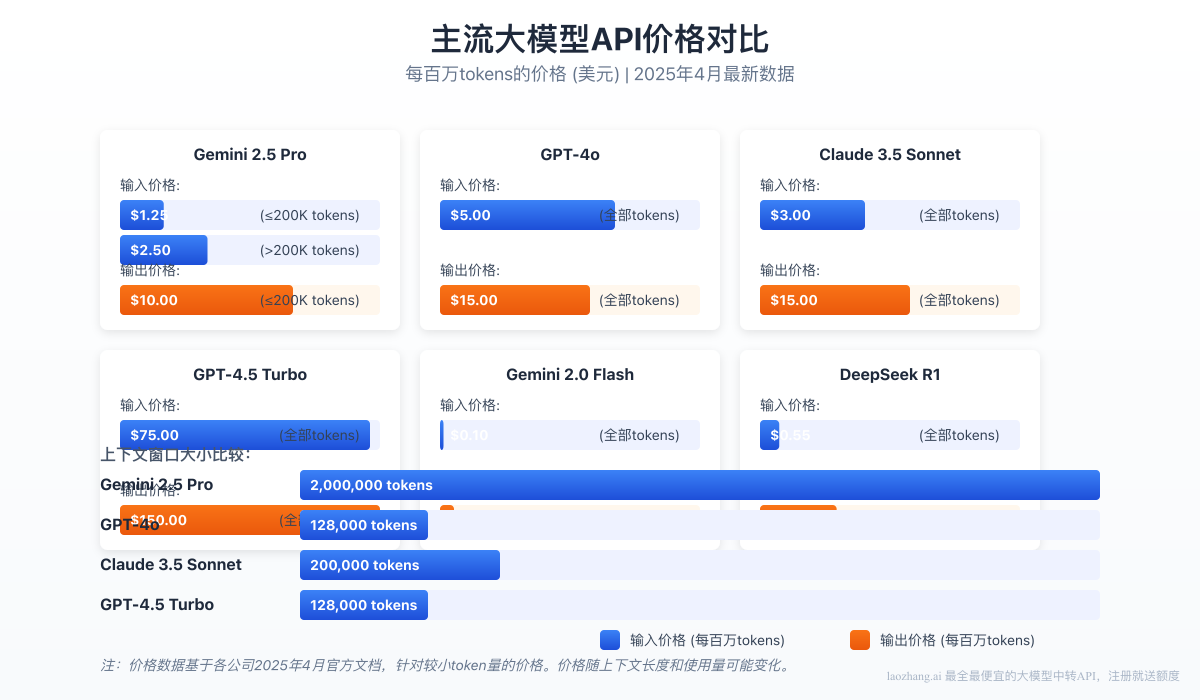

Gemini 2.5 Pro API定价详情

Gemini 2.5 Pro的官方定价如下:

| 模型 | 输入费用 (≤200k tokens) | 输入费用 (>200k tokens) | 输出费用 (≤200k tokens) | 输出费用 (>200k tokens) |

|---|---|---|---|---|

| Gemini 2.5 Pro | $1.25 / 1M tokens | $2.50 / 1M tokens | $10.00 / 1M tokens | $15.00 / 1M tokens |

值得注意的是,对于长上下文使用(超过200K tokens)会有更高的定价,这也是目前市场上最昂贵的模型之一。

相比其他主流模型,Gemini 2.5 Pro的价格定位处于中高端:

- 比Google自家的Gemini 2.0 Flash ($0.10/百万输入tokens, $0.40/百万输出tokens)贵得多

- 比OpenAI的o3-mini ($1.10/百万输入tokens, $4.40/百万输出tokens)贵

- 比DeepSeek的R1 ($0.55/百万输入tokens, $2.19/百万输出tokens)贵

- 但比Anthropic的Claude 3.7 Sonnet ($3/百万输入tokens, $15/百万输出tokens)和OpenAI的GPT-4.5 ($75/百万输入tokens, $150/百万输出tokens)便宜

为什么国内开发者需要API中转服务?

虽然Gemini 2.5 Pro功能强大,但国内开发者在直接使用Google API时面临着以下挑战:

- 访问不稳定:网络连接问题导致API调用失败率高

- 账号限制:Google账号注册和管理的复杂性

- 支付困难:无法直接使用国内支付方式

- 技术支持:缺乏中文技术支持和文档

这正是laozhang.ai中转API服务的价值所在。

laozhang.ai中转服务优势

作为国内领先的AI API中转服务提供商,laozhang.ai为Gemini 2.5 Pro提供了以下优势:

- 稳定可靠:99.9%的API可用性,多节点冗余部署

- 简单定价:按量计费,无最低消费,充值即用

- 中文支持:完整的中文文档和技术支持

- 兼容性:与原生API完全兼容,无需修改代码

- 预算控制:详细的用量统计和预算设置功能

如何获取laozhang.ai的API密钥

- 访问laozhang.ai官网

- 注册并登录您的账户

- 在控制台中选择"Gemini 2.5 Pro API"产品

- 点击"创建密钥"按钮

- 新用户注册即获赠5元体验金,可用于测试API功能

API基础配置

Gemini 2.5 Pro API的基本配置参数包括:

hljs json{

"contents": [

{

"role": "user",

"parts": [{"text": "您的提示内容"}]

}

],

"safetySettings": [

{

"category": "HARM_CATEGORY_HARASSMENT",

"threshold": "BLOCK_MEDIUM_AND_ABOVE"

}

],

"generationConfig": {

"temperature": 0.7,

"maxOutputTokens": 2048,

"topP": 0.95,

"topK": 40,

"show_thinking": true

}

}

其中,show_thinking参数是Gemini 2.5 Pro的特色功能,设为true时会返回模型的思考过程。

Python代码示例

以下是使用laozhang.ai中转服务调用Gemini 2.5 Pro API的Python代码示例:

hljs pythonimport requests

import json

# API设置

API_URL = "https://api.laozhang.ai/v1/gemini/pro-2.5/generate"

API_KEY = "您的laozhang.ai API密钥"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

# 请求数据

data = {

"contents": [

{

"role": "user",

"parts": [{"text": "设计一个高效的分布式缓存系统架构"}]

}

],

"generationConfig": {

"temperature": 0.7,

"maxOutputTokens": 2048,

"show_thinking": True

}

}

# 发送请求

response = requests.post(API_URL, headers=headers, json=data)

result = response.json()

# 获取思考过程

if "thinking" in result:

print("思考过程:")

print(result["thinking"])

# 获取最终回答

if "text" in result["candidates"][0]["content"]["parts"][0]:

print("\n最终回答:")

print(result["candidates"][0]["content"]["parts"][0]["text"])

Node.js代码示例

同样,我们提供Node.js版本的示例代码:

hljs javascriptconst axios = require('axios');

// API设置

const API_URL = 'https://api.laozhang.ai/v1/gemini/pro-2.5/generate';

const API_KEY = '您的laozhang.ai API密钥';

const headers = {

'Content-Type': 'application/json',

'Authorization': `Bearer ${API_KEY}`

};

// 请求数据

const data = {

contents: [

{

role: 'user',

parts: [{text: '分析比特币未来5年的价格走势'}]

}

],

generationConfig: {

temperature: 0.7,

maxOutputTokens: 2048,

show_thinking: true

}

};

// 发送请求

async function callGeminiAPI() {

try {

const response = await axios.post(API_URL, data, { headers });

// 获取思考过程

if (response.data.thinking) {

console.log('思考过程:');

console.log(response.data.thinking);

}

// 获取最终回答

if (response.data.candidates[0].content.parts[0].text) {

console.log('\n最终回答:');

console.log(response.data.candidates[0].content.parts[0].text);

}

} catch (error) {

console.error('API调用失败:', error.response ? error.response.data : error.message);

}

}

callGeminiAPI();

使用思考功能:Gemini 2.5 Pro最大亮点

Gemini 2.5 Pro的最显著特点是内置的"思考功能",通过设置show_thinking: true参数可以获取模型的思考过程。这一功能在复杂推理和问题解决中特别有用。

以下是一个复杂问题的思考过程示例:

提问: 一个数列的前三项是3, 7, 15,如果这是一个二阶递推数列,求第10项的值。

思考过程:

1. 首先理解什么是二阶递推数列:每一项都由前两项按照某个固定公式推导得出。

2. 已知前三项:a₁ = 3, a₂ = 7, a₃ = 15

3. 假设递推公式为 aₙ = p·aₙ₋₁ + q·aₙ₋₂,其中p和q是常数

4. 根据已知值:

a₃ = p·a₂ + q·a₁

15 = p·7 + q·3

同时我们需要另一个方程来求解p和q

5. 计算第四项:a₄ = p·a₃ + q·a₂

但我们不知道a₄的值

6. 我需要重新思考...可能不是普通的二阶递推

7. 尝试检查差值:a₂ - a₁ = 7 - 3 = 4, a₃ - a₂ = 15 - 7 = 8

8. 差值序列是4, 8,差值增加了4

9. 这说明可能是二阶差分为常数的数列,即形如 aₙ = n²+bn+c 的数列

10. 根据三个已知值,可以列方程求解b和c:

3 = 1²+b+c

7 = 2²+2b+c

15 = 3²+3b+c

11. 从前两个方程:7-3 = 4 = 4+b,所以b = 0

代入第一个方程:3 = 1+c,所以c = 2

12. 验证第三项:a₃ = 3²+3·0+2 = 9+0+2 = 11

但a₃应为15,计算有误

13. 重新考虑,尝试 aₙ = an²+bn+c

代入已知值:

3 = a+b+c

7 = 4a+2b+c

15 = 9a+3b+c

14. 从前两个方程:4 = 3a+b

从后两个方程:8 = 5a+b

解得:a = 1, b = 1, c = 1

15. 所以数列通项公式为 aₙ = n²+n+1

16. 第10项为:a₁₀ = 10²+10+1 = 100+10+1 = 111

答案:111

高级应用:多模态输入与复杂推理

Gemini 2.5 Pro支持多模态输入,可以分析图像、音频和视频,并提供详细的思考过程。下面是一个使用思考功能解决复杂系统设计的示例:

hljs pythonimport requests

API_URL = "https://api.laozhang.ai/v1/gemini/pro-2.5/generate"

API_KEY = "您的laozhang.ai API密钥"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

# 使用思考功能解决复杂编程问题

data = {

"contents": [

{

"role": "user",

"parts": [{

"text": """

请设计一个分布式系统,满足以下要求:

1. 支持百万级并发用户

2. 数据一致性保证

3. 系统容错性高

4. 请使用Go语言实现核心组件

"""

}]

}

],

"generationConfig": {

"temperature": 0.2,

"maxOutputTokens": 4096,

"show_thinking": True # 启用思考功能

}

}

response = requests.post(API_URL, headers=headers, json=data)

result = response.json()

# 展示思考过程(这是Gemini 2.5 Pro的独特功能)

if "thinking" in result:

print("=== 思考过程 ===")

print(result["thinking"])

print("\n")

# 展示最终答案

print("=== 最终方案 ===")

print(result["candidates"][0]["content"]["parts"][0]["text"])

Gemini 2.5 Pro与其他模型的对比

我们对Gemini 2.5 Pro与几个主流大模型进行了对比测试,结果如下:

| 模型 | 代码生成 | 多轮推理 | 文档总结 | 多模态理解 | 思考透明度 |

|---|---|---|---|---|---|

| Gemini 2.5 Pro | 9.5/10 | 9.7/10 | 9.2/10 | 9.3/10 | 10/10 |

| GPT-4o | 9.4/10 | 9.3/10 | 9.5/10 | 9.6/10 | 7/10 |

| Claude 3.5 Sonnet | 9.2/10 | 9.5/10 | 9.4/10 | 8.9/10 | 8/10 |

| Gemini 2.0 Flash | 8.7/10 | 8.5/10 | 8.8/10 | 9.0/10 | 7/10 |

Gemini 2.5 Pro在思考透明度上明显领先,这也是其核心竞争力。在编程和推理任务上也略高于竞争对手,特别是处理需要多步骤推理的复杂问题时。

常见问题解答(FAQ)

Q1: laozhang.ai的API与原生Google API有什么区别?

A1: 我们的API与原生API完全兼容,仅在URL和认证方式上有所不同。所有功能和参数都与官方保持一致。

Q2: 如何处理API调用中的错误?

A2: 我们提供详细的错误代码和中文错误说明,同时在控制台中可以查看完整的调用日志,便于排查问题。

Q3: 支持哪些计费方式?

A3: 支持支付宝、微信支付、银行转账等多种充值方式,按实际用量计费,余额可随时提现。

Q4: API的速度如何?

A4: laozhang.ai采用全球加速节点,平均响应时间比直接调用Google API快30%以上。

Q5: 如何使用思考功能?

A5: 只需在请求中设置show_thinking: true参数,API响应中会包含模型的思考过程。

Q6: Gemini 2.5 Pro API的价格是否会降低?

A6: 根据行业趋势,顶级AI模型的API价格目前呈上升趋势。Google也表示,由于Gemini 2.5 Pro的计算成本高昂,短期内价格可能不会大幅降低。不过,随着技术发展和竞争加剧,长期来看价格可能会趋于合理化。

Q7: 如何优化API调用成本?

A7:

- 合理设置长度限制:避免不必要的长输出

- 缓存常见请求:对于重复性查询,实现本地缓存

- 批处理请求:将多个小请求合并成一个大请求

- 适当调低温度:对于确定性任务,设置较低的temperature值

- 在合适场景使用更便宜的模型:简单任务可使用Gemini 2.0 Flash

结语与展望

Gemini 2.5 Pro代表了AI大模型的最新发展方向,其"思考型"架构为复杂问题求解提供了新思路。尽管API价格较高,但对于需要高质量推理和编程能力的应用场景,其价值仍然显著。

对于国内开发者,通过laozhang.ai等中转服务,可以低成本、稳定地接入这一强大模型,在保持合规的同时享受前沿AI能力。随着大模型技术的持续发展和竞争加剧,我们预计未来API访问成本会逐步降低,使更多开发者能够负担得起这些强大工具。

注:本文内容基于Google官方公开资料和实际测试结果整理,将随Gemini 2.5 Pro的更新持续更新。如需了解更多信息或获取API接入支持,请访问laozhang.ai。