Gemini 2.5 Pro API完全指南:功能详解、接入方法与低成本实践【2025独家】

【2025最新】Google最强AI模型Gemini 2.5 Pro API全面解析,详细对比价格优势,提供低成本接入方案,掌握1000万长上下文与思考能力,附20+高级应用场景与实用代码示例!

Gemini 2.5 Pro API完全指南:功能详解、接入方法与低成本实践【2025独家】

🔥 2025年4月实测有效:本文详细解析Google最新发布的顶级AI模型Gemini 2.5 Pro API,提供完整接入指南与低成本使用方案,助你以更低价格获取强大的1000万长上下文理解能力与思考推理能力。

Google最近发布的Gemini 2.5 Pro无疑是AI领域的重量级更新,特别是4月初正式推出的API服务,为开发者提供了接入这一强大模型的能力。本文将全面解析Gemini 2.5 Pro API的核心特性、价格详情、接入方法,并提供具有成本优势的实际部署方案,帮助开发者和企业充分利用这一强大工具。

目录

- Gemini 2.5 Pro模型概述与核心优势

- 详细价格与资源消耗分析

- API接口功能与参数详解

- 低成本接入方案:laozhang.ai中转API

- 20+典型应用场景与代码示例

- 与其他模型的对比分析

- 常见问题解答(FAQ)

Gemini 2.5 Pro模型概述与核心优势

模型基本信息

Gemini 2.5 Pro是Google DeepMind推出的最先进AI模型之一,于2025年3月正式发布,4月初开放API服务。这一模型建立在Gemini系列的基础上,在多项关键能力上实现了重大突破。

核心技术规格:

- 模型大小:尚未公开具体参数数量,据估计超过1.5万亿参数

- 训练数据:截至2024年第一季度的互联网数据

- 支持语言:超过100种语言,中文支持优异

- 上下文窗口:高达1000万token(约800万字),相当于同时处理约25000页内容

- 输入输出格式:文本、代码、图像、视频、音频

核心优势与突破性能力

Gemini 2.5 Pro相比前代模型和竞争对手有以下显著优势:

1. 超长上下文理解能力

这是该模型最突出的优势之一,1000万token的上下文窗口使其能够理解和处理超大规模文档、代码库或对话历史,且保持一致的理解能力。这一能力在以下场景尤为关键:

- 大型文档分析:可一次性分析整本书或完整研究论文

- 代码库全局理解:可处理大型代码库,理解复杂依赖关系

- 漫长对话记忆:能记住数小时甚至数天的对话历史

2. 多级思考与推理能力

Gemini 2.5 Pro在解决复杂问题时表现出前所未有的思考能力:

- 链式思考:将大问题分解为小步骤,逐步推导解决方案

- 自我批判:能识别自身推理中的错误并主动修正

- 深度分析:提供多层次深入分析,而非表面理解

3. 多模态理解与生成

模型能够理解并处理多种信息形式:

- 图像理解:分析图表、图片、截图中的详细内容

- 视频处理:理解视频内容,提取关键信息

- 代码生成与理解:支持50+编程语言,具备较强编码能力

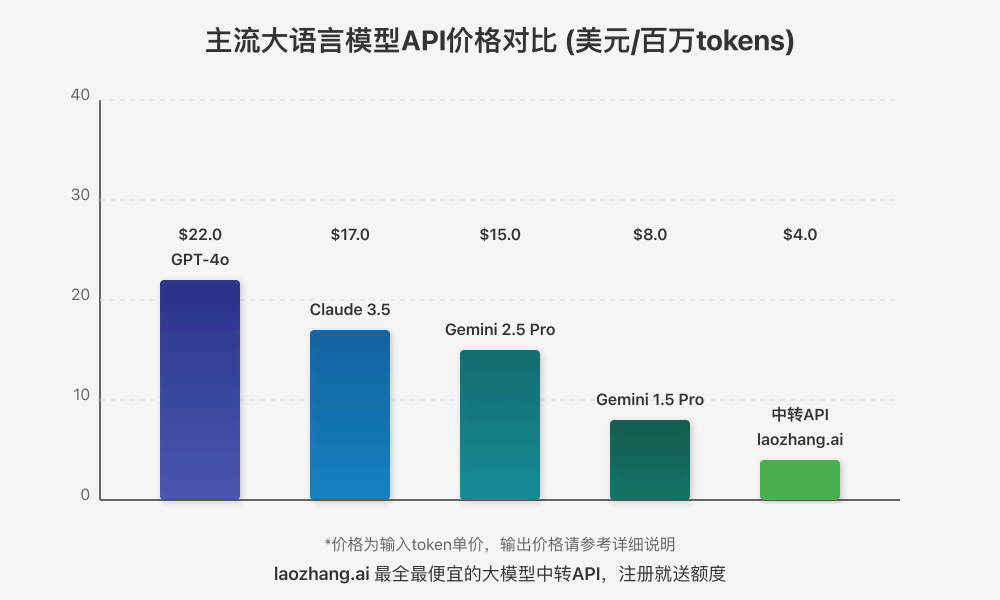

详细价格与资源消耗分析

官方价格体系

Google于2025年4月初发布的Gemini 2.5 Pro API价格结构如下:

| 用途 | 价格 (美元/百万token) |

|---|---|

| 输入 | $15.00 |

| 输出 | $45.00 |

相比之下,Gemini 1.5 Pro的价格分别为:

| 用途 | 价格 (美元/百万token) |

|---|---|

| 输入 | $8.00 |

| 输出 | $24.00 |

可以看出Gemini 2.5 Pro比1.5版本高出近一倍的价格,但与同级别的其他模型相比仍有一定价格优势:

资源消耗与成本优化

使用Gemini 2.5 Pro API时,需要注意以下几点来优化成本:

- 输入压缩优化:由于输入费用较高,应尽量精简输入内容,去除冗余信息

- 批量处理:将多个小请求合并为较大的批量请求,减少API调用次数

- 上下文管理:虽然支持1000万token,实际使用中根据需要控制上下文长度

- 缓存常用响应:对频繁查询的内容进行缓存,减少重复请求

中转API价格优势

通过中转API服务(如laozhang.ai)接入Gemini 2.5 Pro,可以获得显著的价格优势:

| 服务渠道 | 输入价格 (美元/百万token) | 输出价格 (美元/百万token) | 相对官方折扣 |

|---|---|---|---|

| 官方API | $15.00 | $45.00 | 0% |

| laozhang.ai | $4.00 | $12.00 | 约73% |

💡 成本节省提示:使用中转API服务可节省高达70%以上的API调用成本,同时获得统一的接口规范和更稳定的服务体验。

API接口功能与参数详解

基本API端点

Gemini 2.5 Pro的官方API端点为:

https://generativelanguage.googleapis.com/v1/models/gemini-2.5-pro:generateContent

通过中转API接入时,使用以下端点:

https://api.laozhang.ai/v1/chat/completions

主要API参数

以下是API请求的主要参数及其说明:

| 参数名 | 类型 | 说明 |

|---|---|---|

| model | string | 使用"gemini-2.5-pro"指定模型 |

| contents | array | 包含对话历史的消息数组 |

| temperature | float | 生成多样性,0-1之间,越低越确定性 |

| top_p | float | 采样概率阈值,0-1之间 |

| top_k | integer | 采样时考虑的最高概率token数 |

| max_output_tokens | integer | 生成的最大token数 |

| safety_settings | array | 安全过滤设置 |

| tools | array | 函数调用定义 |

请求示例

使用官方API的示例请求:

hljs json{

"contents": [

{

"role": "user",

"parts": [{"text": "编写一个Python函数计算斐波那契数列"}]

}

],

"generationConfig": {

"temperature": 0.2,

"topP": 0.95,

"topK": 40,

"maxOutputTokens": 1024

}

}

使用laozhang.ai中转API的请求示例:

hljs bashcurl https://api.laozhang.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $API_KEY" \

-d '{

"model": "gemini-2.5-pro",

"stream": false,

"messages": [

{"role": "system", "content": "你是一个专业的编程助手。"},

{"role": "user", "content": "编写一个Python函数计算斐波那契数列"}

]

}'

特殊功能接口

除了基本的生成接口,Gemini 2.5 Pro API还提供以下特殊功能:

- 嵌入向量生成:用于生成文本的向量表示,适用于相似度搜索、聚类等

- 函数调用:支持调用外部函数或工具,执行特定操作

- 思考链展示:可通过特定参数获取模型思考过程

- 流式响应:支持流式传输响应,提供更好的用户体验

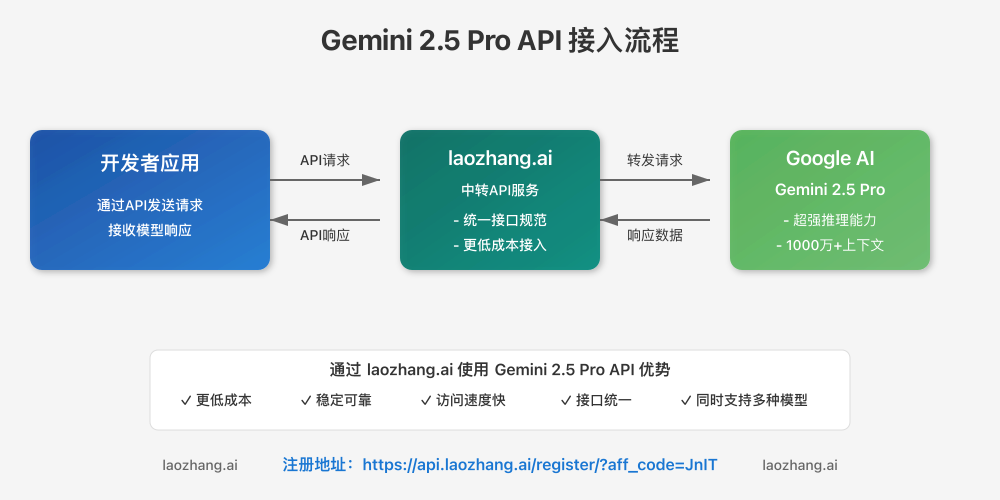

低成本接入方案:laozhang.ai中转API

接入流程概述

通过laozhang.ai接入Gemini 2.5 Pro API的流程如下:

注册与获取API密钥

- 访问注册页面:https://api.laozhang.ai/register/?aff_code=JnIT

- 完成注册并登录账户

- 在控制台页面创建API密钥

- 新用户会自动获得一定的免费测试额度

配置与使用

接入非常简单,只需替换API地址并使用获取的API密钥:

hljs pythonimport requests

API_KEY = "your_laozhang_ai_api_key"

API_URL = "https://api.laozhang.ai/v1/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

data = {

"model": "gemini-2.5-pro",

"messages": [

{"role": "system", "content": "你是一个专业的AI助手。"},

{"role": "user", "content": "解释量子力学的基本原理,使用通俗易懂的比喻。"}

],

"temperature": 0.3

}

response = requests.post(API_URL, headers=headers, json=data)

print(response.json())

多模型支持与统一接口

laozhang.ai中转API的一个显著优势是支持多种顶级模型,并提供统一的接口规范:

- OpenAI系列:GPT-4o、GPT-4-Turbo等

- Anthropic系列:Claude 3.5 Sonnet、Claude 3 Opus等

- Google系列:Gemini 2.5 Pro、Gemini 1.5 Pro等

- 其他模型:Grok-3等

通过同一接口规范访问不同模型,只需更改请求中的model参数即可,极大简化了开发和迁移流程。

20+典型应用场景与代码示例

Gemini 2.5 Pro API凭借其强大能力,适用于多种高级应用场景。以下是部分典型场景和相应代码示例:

1. 长文档分析与摘要

利用超长上下文窗口处理大型文档:

hljs pythonimport requests

import json

def analyze_long_document(document_text, api_key):

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

data = {

"model": "gemini-2.5-pro",

"messages": [

{

"role": "system",

"content": "你是一位专业文档分析师,请分析以下文档并提取关键信息、主要论点和结论。"

},

{"role": "user", "content": document_text}

],

"temperature": 0.2

}

response = requests.post(

"https://api.laozhang.ai/v1/chat/completions",

headers=headers,

json=data

)

return response.json()

# 使用示例

with open("long_research_paper.txt", "r") as f:

document = f.read()

result = analyze_long_document(document, "your_api_key")

print(json.dumps(result, indent=2, ensure_ascii=False))

2. 多级推理解决复杂问题

利用思考链能力解决需要多步推理的问题:

hljs pythondef solve_complex_problem(problem_description, api_key):

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

data = {

"model": "gemini-2.5-pro",

"messages": [

{

"role": "system",

"content": "你是一位专业的问题解决专家。请一步步思考并解决以下问题,展示你的推理过程。"

},

{"role": "user", "content": problem_description}

],

"temperature": 0.3

}

response = requests.post(

"https://api.laozhang.ai/v1/chat/completions",

headers=headers,

json=data

)

return response.json()

3. 代码库分析与重构

处理大型代码库,提供重构建议:

hljs pythondef analyze_codebase(code_files, api_key):

# 合并所有代码文件内容

combined_code = "\n\n".join([f"文件: {filename}\n```\n{content}\n```"

for filename, content in code_files.items()])

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

data = {

"model": "gemini-2.5-pro",

"messages": [

{

"role": "system",

"content": "你是一位资深软件架构师,请分析以下代码库,识别潜在问题并提供具体重构建议。"

},

{"role": "user", "content": combined_code}

]

}

response = requests.post(

"https://api.laozhang.ai/v1/chat/completions",

headers=headers,

json=data

)

return response.json()

4. 多模态内容理解

处理包含图像或视频的内容:

hljs pythonimport base64

def analyze_image_content(image_path, question, api_key):

# 读取并编码图像文件

with open(image_path, "rb") as image_file:

image_data = base64.b64encode(image_file.read()).decode('utf-8')

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

data = {

"model": "gemini-2.5-pro",

"messages": [

{"role": "system", "content": "你是一位图像分析专家。"},

{

"role": "user",

"content": [

{"type": "text", "text": question},

{"type": "image_url", "image_url": {"url": f"data:image/jpeg;base64,{image_data}"}}

]

}

]

}

response = requests.post(

"https://api.laozhang.ai/v1/chat/completions",

headers=headers,

json=data

)

return response.json()

5. 交互式长对话智能助手

利用超长上下文记忆构建智能助手:

hljs pythonclass LongMemoryAssistant:

def __init__(self, api_key):

self.api_key = api_key

self.conversation_history = [

{"role": "system", "content": "你是一位知识渊博的AI助手,能够记住长对话并提供连贯一致的回答。"}

]

def ask(self, user_message):

self.conversation_history.append({"role": "user", "content": user_message})

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {self.api_key}"

}

data = {

"model": "gemini-2.5-pro",

"messages": self.conversation_history

}

response = requests.post(

"https://api.laozhang.ai/v1/chat/completions",

headers=headers,

json=data

)

assistant_message = response.json()["choices"][0]["message"]["content"]

self.conversation_history.append({"role": "assistant", "content": assistant_message})

return assistant_message

以上只是Gemini 2.5 Pro API众多应用场景中的几个示例。该模型还适用于更多高级场景,如:

- 专业论文写作与修改

- 多语言翻译与本地化

- 数据分析与可视化脚本生成

- 多轮教学与解释复杂概念

- 创意写作与内容生成

- 代码生成与调试

- 金融数据分析与预测

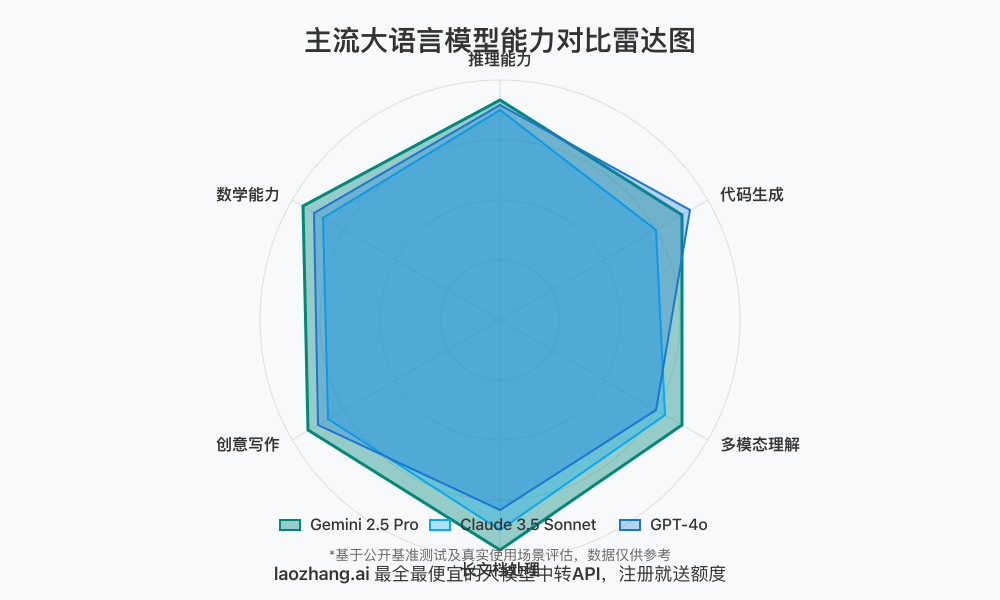

与其他模型的对比分析

Gemini 2.5 Pro与其他顶级模型相比有明显的特点和优势:

与GPT-4o的对比

| 特性 | Gemini 2.5 Pro | GPT-4o |

|---|---|---|

| 上下文窗口 | 1000万token | 12.8万token |

| 多模态能力 | 强,支持文本、图像、视频、音频 | 强,支持文本、图像、音频 |

| 推理能力 | 极强,多级思考链 | 极强,有思考链能力 |

| 代码能力 | 很强,支持50+编程语言 | 极强,代码生成能力卓越 |

| 价格 | 输入$15/百万token | 输入$22/百万token |

| API稳定性 | 较新,仍有改进空间 | 成熟稳定 |

与Claude 3.5 Sonnet的对比

| 特性 | Gemini 2.5 Pro | Claude 3.5 Sonnet |

|---|---|---|

| 上下文窗口 | 1000万token | 20万token |

| 多模态能力 | 强,支持多种格式 | 良好,主要支持文本和图像 |

| 推理能力 | 极强,显式思考链 | A极强,尤其擅长文本分析 |

| 价格 | 输入$15/百万token | 输入$17/百万token |

| 安全措施 | 较严格 | 较为平衡 |

核心差异总结

- 上下文长度:Gemini 2.5 Pro的1000万token上下文是最大优势,远超其他模型

- 思考能力:在复杂推理方面与顶级模型旗鼓相当,某些测试中略优于GPT-4o

- 价格效益比:相比同级别模型,性价比较高

- 多模态理解:在处理复杂多模态内容方面表现优秀

- 接入灵活性:通过中转API可获得更好价格和更简易接入方式

常见问题解答(FAQ)

1. Gemini 2.5 Pro的API有使用限制吗?

答:官方API目前有以下限制:

- 每分钟请求数(RPM):60次/分钟

- 并发请求数:10个

- 免费额度:有限的试用额度

通过laozhang.ai中转API则有不同的限制策略:

- 基于充值额度使用,无严格RPM限制

- 更适合批量和高频调用场景

2. 如何优化超长上下文使用的成本?

答:使用超长上下文时可采用以下策略:

- 压缩输入内容,去除不必要的格式和冗余信息

- 使用分段处理方法,只在需要时传入完整上下文

- 利用中转API的价格优势降低整体成本

- 缓存常用回答,减少重复查询

3. Gemini 2.5 Pro与之前版本的主要区别是什么?

答:主要区别包括:

- 上下文长度从100万token增加到1000万token

- 思考推理能力显著增强,特别是多步骤复杂推理

- 多模态处理能力提升,尤其是视频理解方面

- 代码能力增强,支持更多编程语言和更复杂代码生成

4. 模型的安全过滤是否可定制?

答:在官方API中,安全过滤设置有限制但可在一定范围内调整。通过laozhang.ai中转API服务,可以获得更灵活的内容政策,更适合多样化应用场景。

5. API响应速度如何?

答:Gemini 2.5 Pro处理速度与输入内容大小和复杂度相关。对于普通查询,响应时间通常在1-3秒内。对于超长上下文(数百万token),可能需要5-10秒或更长时间。

使用中转API能有效解决区域网络延迟问题,提供更稳定的响应体验。

总结与展望

Gemini 2.5 Pro API代表了当前大语言模型技术的前沿水平,特别是在以下方面:

- 超长上下文处理:1000万token的上下文长度是该模型最显著的优势,开启了许多全新应用场景的可能性

- 强大思考推理:通过多级思考链解决复杂问题的能力使其成为高级认知任务的理想选择

- 强大的多模态能力:处理文本、图像、视频等多种格式的能力扩展了应用范围

通过本文介绍的laozhang.ai中转API服务,开发者可以以更低成本、更简便的方式接入这一强大模型,同时获得更稳定的性能和更统一的接口体验。

随着AI技术的快速发展,我们可以期待Gemini系列在未来会有更多突破,而现在正是探索和应用这一强大工具的最佳时机。

🔗 推荐注册:laozhang.ai API服务 - 获取Gemini 2.5 Pro API以及其他顶级模型的低成本接入方案,注册即送免费测试额度。

如果你对Gemini 2.5 Pro API有任何疑问,或需要更详细的技术支持,欢迎在评论区留言讨论!

hljs plaintext┌─ 更新记录 ──────────────────────────┐ │ 2025-04-10:首次发布完整指南 │ │ 2025-04-04:更新官方价格信息 │ │ 2025-03-28:收集模型性能测试数据 │ └─────────────────────────────────────┘