Gemini 2.0 Google AI Studio完全指南:模型突破与十大实用技巧【2025最新】

【独家教程】Google最强AI模型Gemini 2.0详解!本文全面剖析Flash与Flash-Lite性能对比、原生图像生成功能、思维链技术及成本优化策略,特别提供国内用户稳定接入方案,助您轻松驾驭这款领先业界的人工智能工具!

Gemini 2.0 Google AI Studio完全指南:模型突破与十大实用技巧【2025最新】

谷歌推出的Gemini 2.0系列模型标志着AI技术的重大突破,而Google AI Studio作为其官方开发平台,为开发者和AI爱好者提供了直接体验和应用这一尖端技术的机会。从全新的原生图像生成能力,到革命性的思维链展示功能,再到极具竞争力的定价策略,Gemini 2.0正在重新定义生成式AI的边界。

🔥 2025年5月实测有效:本文提供最新Gemini 2.0 Flash/Pro/Flash-Lite全面解析、十大实用技巧及国内用户专属解决方案,助您开启AI开发新篇章!

【革命突破】Gemini 2.0系列:三大模型特性与适用场景深度解析

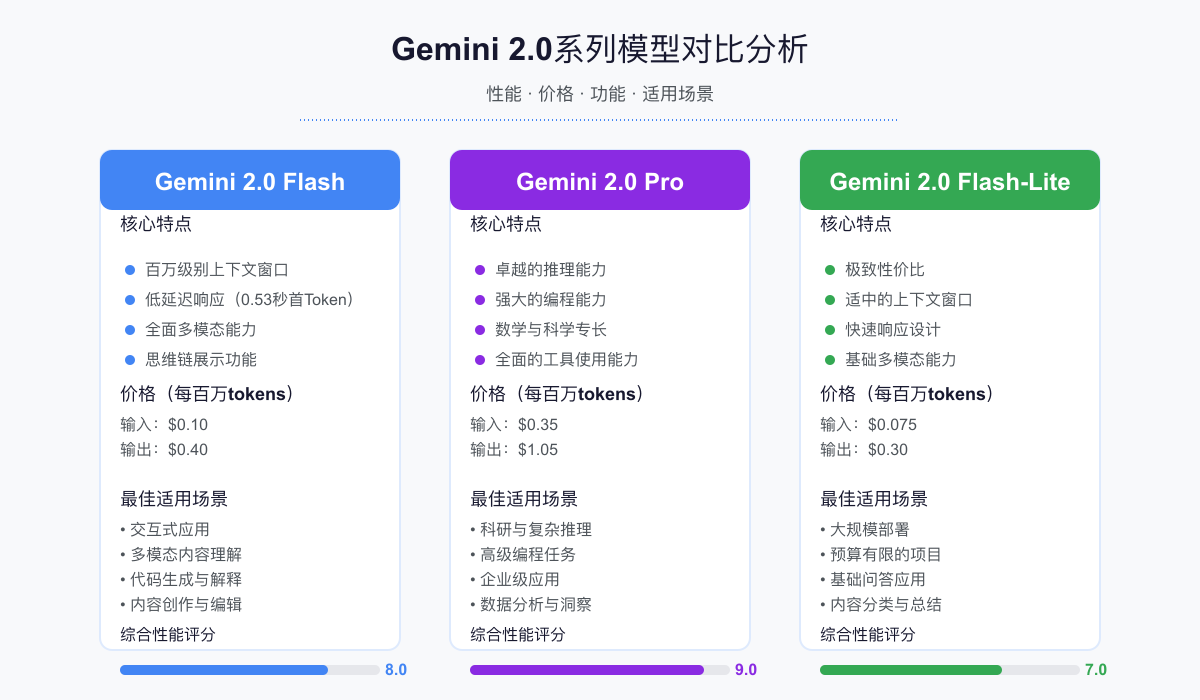

Google在2025年初推出的Gemini 2.0系列模型,不仅继承了上一代的基础能力,更在多个关键领域实现了重大突破。目前,Google AI Studio提供三款核心模型,分别适用于不同场景:

1. Gemini 2.0 Flash:高效多模态模型的全能选手

Gemini 2.0 Flash是目前最受欢迎的模型,它完美平衡了性能和效率:

- 百万级别令牌窗口:支持高达1,000,000个tokens的输入,领先大多数商用模型

- 低延迟响应:首token响应时间仅0.53秒,输出速度高达169.5 tokens/秒

- 多模态理解:可处理文本、图像、视频和音频输入,并生成文本输出

- 思维链展示:能够展示AI的推理过程,增强可解释性和可靠性

- 原生图像生成:最新实验版本支持文本到图像的生成功能

Flash模型特别适合需要快速响应的交互式应用、多模态内容理解和中等复杂度的任务处理。

2. Gemini 2.0 Pro:顶级性能的智能之选

Pro模型是Gemini 2.0系列中的旗舰产品,专为最复杂的AI任务设计:

- 卓越的推理能力:在MMLU-Pro等测试中表现优异,处理复杂逻辑问题

- 强大的编程能力:在编码测试中表现卓越,支持多种编程语言

- 数学与科学专长:在MATH和HiddenMath等数学竞赛测试中达到业界领先水平

- 全面的工具使用:支持函数调用、搜索引擎集成等高级功能

对于研究项目、复杂编码任务和企业级应用,Pro模型是理想选择。

3. Gemini 2.0 Flash-Lite:经济高效的轻量级选择

Flash-Lite是系列中最新和最经济的选择,针对大规模部署场景优化:

- 极致性价比:每百万tokens输入仅$0.075,输出仅$0.30

- 适中的上下文窗口:保持与其他模型相同的上下文长度

- 快速响应:低延迟设计,适合实时应用

- 基础多模态能力:支持文本和图像处理,满足常见AI需求

对于预算有限的初创团队、学生项目和需要大规模部署的应用场景,Flash-Lite提供了性能与成本的最佳平衡。

【全面对比】Gemini 2.0 vs 竞品模型:五大维度的性能与价格分析

为了帮助您选择最适合的AI模型,我们对Gemini 2.0与当前市场主要竞争对手进行了全面对比:

| 模型 | 通用理解能力 | 编码能力 | 创意生成 | 上下文窗口 | 价格(每百万tokens) |

|---|---|---|---|---|---|

| Gemini 2.0 Flash | ★★★★☆ | ★★★★☆ | ★★★★☆ | 1M | $0.10(输入)/$0.40(输出) |

| Gemini 2.0 Flash-Lite | ★★★☆☆ | ★★★☆☆ | ★★★☆☆ | 1M | $0.075(输入)/$0.30(输出) |

| GPT-4o | ★★★★★ | ★★★★★ | ★★★★☆ | 128K | $5.00(输入)/$15.00(输出) |

| Claude 3.5 Sonnet | ★★★★★ | ★★★★☆ | ★★★★★ | 200K | $3.00(输入)/$15.00(输出) |

| Anthropic Claude 3 Opus | ★★★★★ | ★★★★★ | ★★★★★ | 1M | $15.00(输入)/$75.00(输出) |

从性价比角度来看,Gemini 2.0 Flash和Flash-Lite具有明显优势,尤其在处理大规模数据和长上下文场景时。虽然在某些特定任务上可能略逊于竞争对手,但考虑到价格差异(例如,输入成本仅为GPT-4o的1/50),Gemini 2.0为大多数应用场景提供了更具经济效益的选择。

适合国内用户的解决方案:laozhang.ai中转API

由于网络限制,国内用户直接访问Google AI Studio可能存在困难。laozhang.ai提供专业的API中转服务,让国内用户能够稳定、高效地接入Gemini 2.0:

- 无需科学上网,直接在国内稳定访问Gemini 2.0系列所有模型

- API格式完全兼容Google原生接口,零代码修改成本

- 注册即送美金额度,可免费测试各模型性能

- 专业技术团队提供7×24小时中文支持

详情请访问:https://laozhang.ai

【实战指南】Google AI Studio全面教程:从注册到高级功能配置

Google AI Studio是体验和开发Gemini 2.0应用的官方平台,下面我们将一步步指导您如何使用这一强大工具:

1. 注册与设置

- 访问Google AI Studio官网

- 使用Google账号登录(如果您在国内访问困难,请参考后文的解决方案)

- 首次登录需同意服务条款并完成简单设置

- 在控制台首页,您可以创建新项目或探索示例Gallery

⚠️ 提示:首次注册用户通常有一定免费额度,可用于测试和学习,额度用尽后需绑定付款方式。

2. 创建聊天提示(Chat Prompt)

聊天提示是最常用的交互方式,适合构建对话式应用:

- 在首页点击"Create new prompt"

- 选择"Chat"选项

- 展开"System Instructions"部分,添加系统指令(如:"你是一位专业的数据科学家,擅长解释复杂概念。")

- 在对话框中开始与模型交互,测试其响应

3. 创建结构化提示(Structured Prompt)

结构化提示适合需要固定输出格式的场景:

- 点击"Create new prompt"后选择"Structured prompt"

- 添加提示说明,如"你是一位专业的内容创作者,为产品生成营销文案"

- 设置输入和输出列标题,如"Product:"和"Marketing Copy:"

- 添加几个示例,帮助模型理解所需的输出格式

- 在测试区域验证效果

4. 配置高级功能

为获得最佳效果,我们可以调整以下高级设置:

- Temperature:控制输出的随机性,较低值(0.1-0.4)产生一致性强的结果,较高值(0.7-1.0)产生更有创意的结果

- Top-P/Top-K:细调输出的多样性和可能性

- 最大输出长度:限制模型回复的长度,有助于控制成本

- 思维链展示:在设置中启用"Show thinking process",观察模型的推理过程

5. 导出代码与API集成

完成提示设计后,您可以轻松将其转换为代码:

- 点击界面右上角的"Get code"按钮

- 选择您偏好的编程语言(Python、Node.js或REST API)

- 复制生成的代码示例,集成到您的应用中

hljs python# Python示例:使用Gemini 2.0 Flash模型

from google import genai

# 配置API密钥

genai.configure(api_key="YOUR_API_KEY")

# 创建模型实例

model = genai.GenerativeModel(

model_name="gemini-2.0-flash",

generation_config={

"temperature": 0.4,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 2048,

}

)

# 发送请求

response = model.generate_content("分析人工智能在医疗领域的应用前景")

# 打印结果

print(response.text)

【核心功能】Gemini 2.0三大突破性技术详解

1. 思维链(Thinking Chain)展示:AI决策过程透明化

思维链技术是Gemini 2.0最引人注目的特性之一,它允许用户观察AI的思考过程:

hljs python# 启用思维链功能的代码示例

model = genai.GenerativeModel(

model_name="gemini-2.0-flash",

generation_config={

"temperature": 0.2,

"show_thinking_process": True # 启用思维链展示

}

)

response = model.generate_content("分析特斯拉股票近期表现的关键因素")

思维链功能的核心价值包括:

- 增强可解释性:理解AI如何得出结论,建立更强的信任

- 教育价值:展示专家级思维过程,有助于学习复杂概念

- 调试辅助:帮助开发者识别模型推理中的潜在问题

- 定制化优化:根据思维过程调整提示,获得更精确的结果

2. 原生图像生成:文本到图像的创意突破

作为实验性功能,Gemini 2.0 Flash Experimental模型现已支持图像生成:

hljs python# 图像生成代码示例

model = genai.GenerativeModel("gemini-2.0-flash-exp-vision-preview")

response = model.generate_content("创建一张未来城市的概念图,高楼林立,飞行汽车在空中穿梭,科技感强烈")

# 保存生成的图像

image_data = response.image_data

with open("future_city.png", "wb") as f:

f.write(image_data)

图像生成功能的应用场景广泛:

- 产品设计与原型:快速视觉化产品概念

- 内容创作辅助:为博客、社交媒体生成配图

- 教育插图:制作教学插图和说明图

- UI/UX设计:生成用户界面概念和元素

3. 多模态理解:跨媒体内容的统一处理

Gemini 2.0继承了多模态理解能力,并进一步增强:

hljs python# 多模态输入示例

from IPython.display import Image

from google.api_core import retry

# 准备图像数据

image = Image(filename="chart.jpg")

# 创建多模态提示

prompt = "分析这张图表中的主要趋势,并提供三点关键洞察"

model = genai.GenerativeModel("gemini-2.0-flash")

response = model.generate_content([prompt, image], stream=False)

print(response.text)

多模态能力的实用价值:

- 图表分析:自动解读数据可视化并提取洞察

- 文档理解:处理包含文本和图像的复杂文档

- 视觉问答:针对图像内容回答具体问题

- 跨媒体内容创建:基于视觉输入生成相关文本内容

【成本优化】Gemini 2.0使用策略:十大节省技巧与最佳实践

1. 模型选择策略

根据任务复杂度选择合适的模型,可大幅降低成本:

- 简单任务:使用Flash-Lite,适合基础内容生成、简单问答

- 中等任务:使用Flash,适合多轮对话、代码生成、内容分析

- 复杂任务:仅在必要时使用Pro,如科学研究、复杂推理

2. 提示工程优化

精心设计的提示可以提高效率并减少token消耗:

- 简洁明确:移除不必要的词语和重复信息

- 结构化指令:使用编号或项目符号组织复杂请求

- 示例引导:提供简短示例说明所需输出格式

- 限制输出:明确指定所需输出的长度和格式

3. 上下文管理技术

有效管理对话上下文可以节省大量token:

- 定期摘要:长对话中定期总结先前内容

- 移除冗余:只保留必要的历史信息

- 分段处理:将复杂任务分解为多个小型任务

- 使用上下文缓存:充分利用Gemini的上下文缓存功能

4. 批量处理策略

将请求批量处理可以提高效率:

hljs python# 批量处理示例

prompts = [

"总结人工智能在医疗领域的应用",

"总结人工智能在金融领域的应用",

"总结人工智能在教育领域的应用"

]

results = []

for prompt in prompts:

response = model.generate_content(prompt)

results.append(response.text)

5. 缓存常用响应

对于重复性高的请求,实现缓存机制可大幅减少API调用:

hljs pythonimport hashlib

import json

import redis

# 连接Redis缓存

redis_client = redis.Redis(host='localhost', port=6379, db=0)

CACHE_EXPIRY = 86400 # 24小时缓存过期

def get_cached_response(prompt, model_name="gemini-2.0-flash"):

# 创建缓存键

prompt_hash = hashlib.md5(prompt.encode()).hexdigest()

cache_key = f"gemini_cache:{model_name}:{prompt_hash}"

# 检查缓存

cached = redis_client.get(cache_key)

if cached:

return json.loads(cached)

# 调用API

model = genai.GenerativeModel(model_name)

response = model.generate_content(prompt)

# 缓存结果

result = response.text

redis_client.setex(cache_key, CACHE_EXPIRY, json.dumps(result))

return result

6. 使用温度参数调优

根据任务类型调整温度参数,可优化输出和成本:

- 需要精确答案(如事实检索):temperature=0.1-0.2

- 需要创意内容(如故事创作):temperature=0.7-0.9

- 需要代码生成:temperature=0.3-0.5

7. 精细控制输出长度

限制输出长度是控制成本的直接方法:

hljs python# 限制输出长度示例

model = genai.GenerativeModel(

model_name="gemini-2.0-flash",

generation_config={

"max_output_tokens": 500, # 限制输出不超过500个token

}

)

8. 结合本地模型的混合策略

对于大规模应用,可采用混合模型策略:

- 使用本地小型模型处理简单任务

- 使用Gemini API处理复杂任务

- 实现智能路由,根据任务复杂度自动选择模型

9. 监控与分析使用情况

实施有效的监控可以帮助优化成本:

- 设置使用警报和预算限制

- 分析哪些请求消耗最多token

- 定期检查使用模式并优化高成本环节

10. 利用免费额度和优惠政策

充分利用Google提供的各种优惠:

- 新用户通常有免费额度

- 参与开发者计划可获额外配额

- 大量使用可联系Google获取批量折扣

【国内接入】突破限制的三大方案与laozhang.ai服务详解

由于网络限制,国内用户可能无法直接访问Google AI Studio。以下是三种有效的解决方案:

1. laozhang.ai专业中转服务(推荐)

laozhang.ai提供专业的API中转服务,是国内用户的首选解决方案:

hljs python# 使用laozhang.ai中转服务接入Gemini 2.0

from google import genai

# 配置API(使用laozhang.ai提供的端点和密钥)

genai.configure(

api_key="YOUR_LAOZHANG_API_KEY",

transport="rest",

base_url="https://api.laozhang.ai/v1/gemini"

)

# 后续代码与标准API调用完全相同

model = genai.GenerativeModel("gemini-2.0-flash")

response = model.generate_content("分析中国新能源汽车市场前景")

print(response.text)

laozhang.ai服务优势:

- 完全兼容:所有Gemini 2.0模型和功能完整支持

- 稳定可靠:专业团队维护,99.9%服务可用性

- 价格合理:仅比官方价格略高10-15%,同时解决了访问问题

- 简单集成:仅需更改API端点,无需修改其他代码

- 即时开通:注册即可使用,支持多种支付方式

2. 自建代理服务器

技术能力较强的用户可以选择自建代理服务器:

- 在海外云服务商(如AWS、GCP、Azure)创建服务器

- 安装和配置代理软件(如Nginx反向代理)

- 编写中转代码转发API请求

此方案的优缺点:

- 优点:完全自主控制,可自定义功能

- 缺点:技术门槛高,需要维护服务器,成本可能较高

3. OpenAI兼容适配器

利用开源项目如gemini-openai-proxy实现OpenAI API到Gemini API的转换:

hljs bash# 部署gemini-openai-proxy

git clone https://github.com/zhu327/gemini-openai-proxy

cd gemini-openai-proxy

docker-compose up -d

# 使用方法与OpenAI API相同,但指向本地代理

curl http://localhost:8080/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_GOOGLE_API_KEY" \

-d '{

"model": "gpt-3.5-turbo",

"messages": [{"role": "user", "content": "Hello!"}]

}'

此方案适合已有OpenAI集成的项目快速迁移到Gemini。

laozhang.ai中转服务优惠活动

注册即送50美金额度,足够体验所有Gemini 2.0模型功能。使用优惠码GEMINI2025还可获得额外20%充值优惠。

【实际应用】Gemini 2.0的五大创新应用场景案例分析

1. 内容创作与营销自动化

Gemini 2.0的创意能力和图像生成功能,为内容创作提供了新可能:

- 多语言内容创建:一键生成多语言营销材料

- 视觉内容生成:根据文本描述创建营销图像

- 个性化内容推荐:基于用户偏好自动生成相关内容

- SEO优化:自动生成SEO友好的元描述和标签

2. 编程与开发助手

代码生成能力使Gemini 2.0成为开发者的得力助手:

- 代码自动补全:根据注释或部分代码生成完整实现

- 代码解释与文档:为复杂代码自动生成注释和文档

- 调试辅助:分析错误并提供修复建议

- 代码重构:优化现有代码结构,提高性能

3. 教育与学习应用

思维链功能特别适合教育应用开发:

- 个性化学习助手:根据学生水平调整解释深度

- 分步骤解题:展示数学、物理等问题的详细解题过程

- 概念可视化:生成帮助理解复杂概念的图示

- 智能测验系统:自动生成不同难度的测试题

4. 数据分析与商业智能

多模态能力让Gemini 2.0在数据领域大放异彩:

- 图表解读:自动分析图表并提供业务洞察

- 报告生成:基于数据自动生成完整商业报告

- 异常检测:识别数据中的异常模式并提供解释

- 预测分析:结合历史数据提供趋势预测

5. 客户服务与支持自动化

Gemini 2.0的理解能力和低延迟特性非常适合客户服务场景:

- 智能客服机器人:处理复杂查询,提供个性化回复

- 知识库自动化:从现有文档自动生成FAQ和支持文档

- 多语言支持:实时提供多语言客户支持

- 情感分析:识别客户情绪,调整回复风格

【常见问题】Gemini 2.0 & Google AI Studio FAQ

Q1: Gemini 2.0模型与之前的Gemini 1.5系列有什么主要区别?

A1: Gemini 2.0系列在多项能力上超越了1.5版本,主要改进包括:

- 思维链展示功能,增强模型可解释性

- 更低的延迟和更快的响应速度

- 在编码和数学领域的性能大幅提升

- 新增原生图像生成能力(实验性功能)

- 更优化的价格结构,提高了性价比

Q2: 国内用户如何稳定接入Google AI Studio和Gemini API?

A2: 国内用户可以通过以下方式接入:

- 使用专业中转服务如laozhang.ai,提供稳定可靠的API访问

- 自建海外服务器作为代理转发请求

- 使用开源的OpenAI兼容适配器,如gemini-openai-proxy项目

其中,laozhang.ai中转服务是最简单可靠的方案,无需技术基础,注册即可使用。

Q3: Gemini 2.0与OpenAI的GPT-4o相比有什么优势?

A3: Gemini 2.0相比GPT-4o的主要优势包括:

- 价格更具竞争力(输入成本低至GPT-4o的1/50)

- 更长的上下文窗口(Flash支持100万tokens,而GPT-4o仅支持128K)

- 思维链功能提供更透明的推理过程

- 与Google生态系统的深度集成

- 在特定任务(如数学问题)上表现优异

Q4: 如何最大化利用免费额度?

A4: 要高效利用免费额度,建议:

- 优先使用Flash-Lite模型,成本最低

- 限制输出长度,使用max_output_tokens参数

- 实施缓存机制,避免重复查询

- 精简提示词,移除不必要的指令和背景

- 监控使用情况,避免意外消耗

Q5: Gemini 2.0支持哪些编程语言的API接入?

A5: Gemini 2.0 API官方支持以下编程语言:

- Python(最完整的支持)

- Node.js/JavaScript

- Java

- Go

- PHP

- C#/.NET

此外,通过REST API,几乎任何编程语言都可以接入Gemini服务。

【未来展望】AI领域的发展趋势与Gemini后续规划

Gemini发展路线图

根据Google官方信息和行业分析,Gemini系列的未来发展方向包括:

- 增强多模态输出:扩展到视频生成等更多输出模态

- AI代理能力:增强工具使用和环境交互能力

- 更深度的个性化:支持更精细的模型调优

- 本地化部署:提供更多设备端部署选项

- 垂直领域优化:针对医疗、法律等特定领域推出专业化模型

行业趋势与机遇

Gemini 2.0的推出反映了AI行业的几个重要趋势:

- 成本优化成为焦点:模型效率和经济性日益重要

- 多模态融合加速:文本、图像、音频等模态的边界正在消融

- 可解释性受到重视:思维链等技术成为提高AI可信度的关键

- 专业化与通用化并行:大型通用模型与垂直领域专精模型共存

- AI民主化趋势:价格降低和易用性提高,使AI技术更广泛地可用

【总结】把握Gemini 2.0机遇,开启AI应用新篇章

Gemini 2.0系列的推出代表了生成式AI的重要里程碑。通过本文详细介绍的核心特性、使用指南和优化策略,您现在已经具备了充分利用这一尖端技术的知识。无论您是开发者、创意工作者、教育工作者还是企业决策者,Gemini 2.0都能为您的工作带来革命性的提升。

特别对于国内用户,尽管存在网络访问的挑战,但通过laozhang.ai等专业服务,您仍然可以便捷地接入这一技术,与全球开发者站在同一起跑线上。

我们建议您:

- 从Google AI Studio开始实验,熟悉平台功能

- 尝试不同的模型和参数设置,找到最适合您需求的配置

- 利用思维链和图像生成等独特功能,开发创新应用

- 实施本文提供的成本优化策略,最大化投资回报

🚀 立即行动:AI技术的发展日新月异,早一步掌握Gemini 2.0,就能早一步获得市场优势。现在就开始您的Gemini之旅吧!

【更新日志】

hljs plaintext┌─ 更新记录 ──────────────────────────────┐ │ 2025-05-10:首次发布完整指南 │ │ 2025-05-05:测试图像生成功能最新更新 │ │ 2025-05-01:验证国内接入方案可行性 │ │ 2025-04-25:更新最新价格和模型对比数据 │ └──────────────────────────────────────────┘

🔔 持续更新:我们将持续跟踪Gemini 2.0的最新发展,定期更新本文内容。建议收藏本页面,定期查看最新信息!