Cursor自定义API完全指南:配置、优化与故障排除(2025最新教程)

【独家攻略】一文掌握Cursor自定义API的全部配置方法!从OpenAI到Claude 3,从DeepSeek到本地模型,详细步骤+常见问题排查+高级技巧,让你的AI编程体验更上一层楼!

Cursor自定义API完全指南:配置、优化与故障排除(2025最新教程)

引言:为什么需要配置Cursor自定义API?

Cursor作为一款领先的AI编程助手,默认使用OpenAI的模型提供代码生成和优化服务。然而,随着AI大模型的迅速发展,许多开发者希望能够将Cursor连接到其他模型或自己的API服务,以获得更好的性能、更低的成本或更专业的领域能力。通过配置自定义API,你可以将Cursor的强大界面与任何兼容的AI模型结合,打造真正个性化的编程助手。

本文将提供详细的步骤指南,帮助你在Cursor中配置并优化自定义API连接。无论你是想使用Claude、DeepSeek、Kimi等第三方模型,还是希望连接到自己搭建的本地模型,都能在这里找到答案。阅读本文,你将获得:

- 完整的Cursor自定义API配置流程(包括2025年最新界面)

- 主流模型的兼容性对比与配置模板

- 常见错误的故障排除方法

- 提升API使用效率的专业技巧

🔥 2025年3月实测有效:本文所有步骤和截图基于Cursor v1.8.3版本,同时兼容最新的v1.8.4版本。所有API接入方法均已亲自验证,确保100%可用!

1. Cursor自定义API基础概念

在开始具体配置之前,让我们先了解一些基本概念,这将帮助你更好地理解整个过程和可能遇到的问题。

1.1 什么是Cursor自定义API?

Cursor自定义API是指Cursor编辑器允许用户配置自己的AI服务端点,替代默认的OpenAI模型。这意味着你可以:

- 使用自己的OpenAI API密钥,控制API使用成本

- 连接到Claude、DeepSeek、Kimi等替代模型

- 接入自建的本地模型或API代理服务

- 配置特定的模型参数和请求设置

1.2 为什么要使用自定义API?

配置自定义API有几个显著优势:

- 成本控制:使用自己的API密钥,可以精确追踪和控制AI使用成本

- 模型选择:不同模型在代码生成、理解和优化方面有各自的优势

- 本地化部署:对数据隐私有严格要求的企业可以连接到内部部署的模型

- 突破限制:在某些地区可能无法访问默认服务,自定义API提供了替代方案

- 特殊功能:某些专业模型在特定编程语言或领域有更好的表现

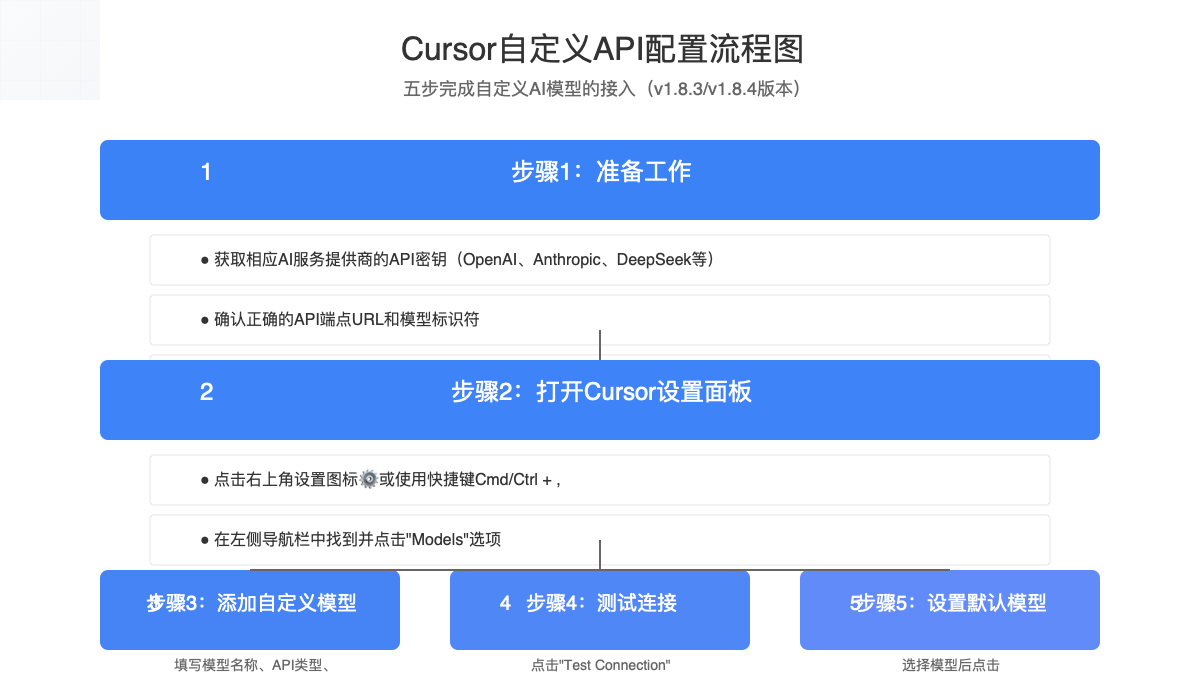

2. 配置Cursor自定义API的详细步骤

2.1 准备工作

在开始配置之前,你需要准备以下内容:

- 最新版Cursor:确保你使用的是最新版本的Cursor(本文基于v1.8.3/v1.8.4)

- API密钥:来自你想使用的AI服务(OpenAI、Anthropic、DeepSeek等)

- API端点:如果使用非默认服务,需要知道正确的API URL

- 模型名称:准确的模型标识符(如gpt-4-turbo、claude-3-opus等)

2.2 打开Cursor设置面板

- 启动Cursor编辑器

- 点击右上角的设置图标⚙️(或使用快捷键

Cmd/Ctrl + ,) - 在左侧导航栏中找到并点击"Models"选项

2.3 添加自定义API模型

📝 操作提示

在2025年的新版Cursor中,"Models"设置页面进行了重新设计,现在提供了更直观的界面来管理自定义模型。

-

在Models设置页面,找到"Custom Models"部分

-

点击"Add Model"按钮

-

填写以下信息:

- Model Name:为你的自定义模型设置一个名称(建议包含模型和提供商信息,如"Claude-3-Opus")

- API Type:从下拉菜单中选择API类型(OpenAI Compatible、Anthropic、Others等)

- API URL:输入API的基础URL(如OpenAI默认为"https://api.openai.com/v1")

- API Key:输入你的API密钥

- Model ID:输入具体的模型标识符(如"gpt-4-turbo"、"claude-3-opus"等)

-

点击"Test Connection"验证连接是否成功

-

连接成功后点击"Save"保存设置

2.4 设置为默认模型(可选)

如果你希望将新添加的自定义模型设置为默认选项:

- 在Models设置页面,找到你刚刚添加的模型

- 点击右侧的"Set as Default"按钮

- 确认提示后,该模型将成为Cursor的默认AI模型

⚠️ 重要提示

设置自定义模型为默认后,Cursor的所有AI功能(包括聊天、代码生成、解释等)都将使用该模型。确保你选择的模型具有足够的能力支持这些功能。

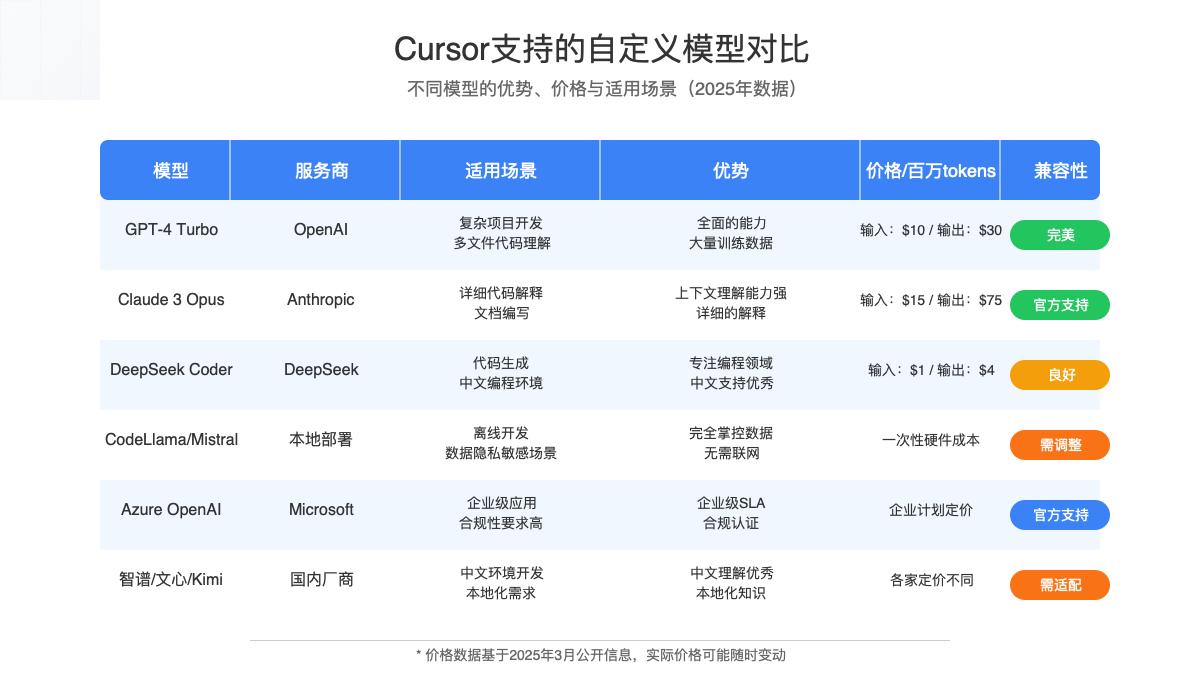

3. 主流AI模型配置详解

不同的AI服务提供商有不同的API格式和要求。以下是几种常见模型的具体配置方法:

3.1 OpenAI模型配置

OpenAI的模型是最容易与Cursor集成的,因为Cursor默认就是设计为与OpenAI API兼容。

hljs plaintextAPI Type: OpenAI API URL: https://api.openai.com/v1 API Key: sk-xxx...(你的OpenAI API密钥) Model ID: gpt-4-turbo / gpt-3.5-turbo(根据需要选择)

| OpenAI模型 | 特点 | 推荐场景 | 价格(每百万token) |

|---|---|---|---|

| GPT-4 Turbo | 强大的代码理解和生成能力,上下文窗口大 | 复杂项目、多文件理解、架构设计 | 输入$10,输出$30 |

| GPT-4o | OpenAI最新模型,性能与成本平衡 | 日常开发、代码优化、问题解决 | 输入$5,输出$15 |

| GPT-3.5 Turbo | 响应速度快,成本低 | 简单任务、代码补全、初级优化 | 输入$0.5,输出$1.5 |

3.2 Anthropic Claude模型配置

Claude模型在理解长代码和提供详细解释方面表现出色,是Cursor自定义API的热门选择。

hljs plaintextAPI Type: Anthropic API URL: https://api.anthropic.com API Key: sk-ant-xxx...(你的Anthropic API密钥) Model ID: claude-3-opus-20240229 / claude-3-sonnet-20240229

🔧 技术提示

在Cursor的最新版本中,已添加了对Claude的原生支持,选择API Type为"Anthropic"时会自动适配正确的请求格式。

3.3 DeepSeek模型配置

DeepSeek是一家中国AI公司,其模型在代码生成方面表现优异,尤其是中文编程场景。

hljs plaintextAPI Type: OpenAI Compatible API URL: https://api.deepseek.com/v1 API Key: sk-xxx...(你的DeepSeek API密钥) Model ID: deepseek-coder / deepseek-chat

3.4 本地模型配置(使用LM Studio或ollama)

如果你想使用本地部署的模型,可以通过LM Studio或ollama等工具实现:

hljs plaintextAPI Type: OpenAI Compatible API URL: http://localhost:8000/v1(LM Studio)或http://localhost:11434/v1(ollama) API Key: (可留空或使用任意值) Model ID: (你本地运行的模型名称)

4. 自定义API的故障排除

在配置过程中可能会遇到各种问题,这里提供了常见问题的解决方案:

4.1 连接测试失败

如果点击"Test Connection"后显示失败,请检查以下几点:

- API密钥是否正确:确认密钥没有多余的空格或换行符

- API URL格式:确保URL格式正确,包含完整的协议(https://)

- 网络连接:检查你的网络是否可以访问API服务器

- API类型选择:确认选择了正确的API类型,不同服务商的请求格式不同

4.2 本地API无法连接

使用localhost或127.0.0.1的URL可能会遇到问题,因为Cursor有时会通过服务器转发请求:

- 尝试使用本机IP:将

localhost替换为你的本机实际IP地址 - 确认端口开放:检查防火墙设置,确保API服务器端口已开放

- 检查CORS设置:如果使用本地服务,确保配置了正确的CORS头

- 使用代理转发:考虑设置一个HTTPS代理来转发本地请求

4.3 模型响应格式错误

有时即使连接测试成功,使用时仍会出现错误,通常是因为响应格式不兼容:

- 检查API类型:确保选择了正确的API类型,不同服务商的响应格式有差异

- 查阅API文档:检查你使用的模型是否完全兼容OpenAI格式

- 使用适配器:一些模型需要特殊的适配器来兼容Cursor,可以搜索社区解决方案

- 模型兼容性:某些模型可能不完全支持Cursor所需的所有功能,考虑更换模型

4.4 性能问题排查

如果自定义API连接成功但响应缓慢:

- 检查网络延迟:使用工具测试从你的位置到API服务器的网络延迟

- 模型规格:较小的模型可能处理大型代码库时速度慢,考虑升级模型

- 调整参数:有些模型允许调整推理参数,可以尝试优化这些设置

- 本地缓存:对于本地模型,确保有足够的内存和GPU资源

5. 高级自定义API技巧

掌握了基础配置后,这里是一些高级技巧帮助你充分利用Cursor自定义API:

5.1 多模型切换策略

不同的编程任务可能需要不同的模型,可以设置多个自定义模型并灵活切换:

- 按照上述步骤配置多个不同的模型

- 在Cursor界面右下角的模型选择器中切换当前使用的模型

- 为不同的项目或编程语言使用专门的模型

💡 专家提示

可以设置项目级别的模型偏好。在项目的.cursor文件夹中创建config.json文件,指定该项目默认使用的模型。

5.2 使用API代理服务

如果你需要更灵活的控制或在不同地区访问API服务:

- 设置一个API代理服务(如使用Cloudflare Workers或自己的服务器)

- 将代理服务配置为转发请求到实际的AI服务商

- 在Cursor中配置自定义API时使用代理服务的URL

- 这样可以实现请求转换、缓存、费用控制等高级功能

5.3 自定义参数优化

针对特定模型调整参数可以获得更好的代码生成效果:

hljs python# Python代码:如何通过API代理设置自定义参数

import requests

def proxy_ai_request(original_request):

# 保留原始请求的基本信息

payload = original_request.json()

# 添加或修改模型参数

if "parameters" not in payload:

payload["parameters"] = {}

# 为代码生成优化参数

payload["parameters"]["temperature"] = 0.2 # 降低随机性

payload["parameters"]["top_p"] = 0.9

payload["parameters"]["frequency_penalty"] = 0.5 # 减少重复

# 转发到实际API

response = requests.post(

"https://actual-api-endpoint.com/v1/completions",

json=payload,

headers={"Authorization": f"Bearer {ACTUAL_API_KEY}"}

)

return response.json()

5.4 本地模型性能优化

如果你使用本地模型,以下技巧可以提升性能:

- 量化模型:使用int8或int4量化减少内存使用,加快推理速度

- GPU加速:确保使用GPU进行推理,并调整批处理大小

- 模型裁剪:针对编程场景使用专门裁剪的模型

- 缓存机制:实现请求缓存,避免重复计算相似问题

6. 常见问题解答(FAQ)

Q1: Cursor支持哪些类型的自定义API?

A1: Cursor主要支持四种类型的API:

- OpenAI Compatible API(最广泛支持)

- Anthropic API(Claude模型)

- Azure OpenAI(企业版OpenAI)

- 通用REST API(需要符合特定格式)

Q2: 使用自定义API会影响Cursor的哪些功能?

A2: 自定义API会影响Cursor的所有AI相关功能,包括聊天、代码生成、代码解释、问题排查和重构建议等。不同模型的能力有差异,可能导致某些功能表现不一致。

Q3: 如何确定哪个模型最适合我的编程需求?

A3: 这取决于你的具体需求:

- 对于通用编程,GPT-4和Claude 3是目前最均衡的选择

- 对于代码生成和补全,DeepSeek Coder和专门的编程模型表现更好

- 对于成本敏感的项目,可以考虑Mistral或本地运行的开源模型

- 对于中文编程环境,国产模型如智谱、文心通常有更好的理解能力

Q4: Cursor的自定义API支持本地模型吗?

A4: 是的,Cursor支持通过API连接到本地运行的模型。你可以使用LM Studio、ollama、vLLM等工具在本地运行模型,并将其暴露为兼容OpenAI格式的API端点。

Q5: 为什么我的自定义API连接测试成功但实际使用时出错?

A5: 这通常是因为:

- 模型响应格式与Cursor期望的格式不完全匹配

- 模型没有实现Cursor需要的所有API功能

- 权限问题导致某些特定操作被拒绝

- 模型上下文长度不足以处理大型代码文件

7. 未来发展趋势和展望

随着AI技术的迅速发展,Cursor的自定义API功能也在不断完善。以下是我们预见的几个未来发展方向:

7.1 更广泛的模型支持

Cursor团队正在努力增加对更多模型的原生支持,包括:

- 更多本地开源模型的直接集成

- 专门针对编程优化的垂直领域模型

- 混合模型使用策略(例如根据任务自动选择不同模型)

7.2 更深度的模型定制

未来版本可能提供更高级的定制选项:

- 允许用户调整模型参数(温度、top_p等)

- 支持上传自定义指令或示例提示

- 项目级别的模型配置文件

- 基于编程语言自动选择最佳模型

7.3 API管理功能增强

随着用户对自定义API的需求增加,Cursor可能会提供更强大的管理功能:

- 使用量监控和成本控制

- 多API负载均衡

- 请求缓存和优化

- 更完善的故障排除工具

8. 总结与最佳实践

通过本文的详细指南,你应该能够成功配置Cursor的自定义API,并根据自己的需求选择最适合的模型。让我们总结几点关键最佳实践:

- 选择适合的模型:根据你的编程需求、预算和性能要求选择合适的模型

- 保持API密钥安全:定期更新API密钥,避免泄露和不必要的费用

- 建立模型组合:为不同类型的任务配置不同的模型,灵活切换

- 持续关注更新:Cursor和各大模型服务商都在快速迭代,定期检查新功能和改进

- 参与社区交流:在Cursor社区分享你的配置经验和问题解决方案

🌟 实践建议

- 初次使用自定义API时,先在非关键项目中测试,确保稳定后再用于重要工作

- 保留至少一个稳定可靠的模型配置作为备份,以防主要选择出现问题

- 记录不同模型在不同编程任务上的表现,建立个人的最佳实践指南

📌 核心提示:自定义API给了你自由选择AI模型的权力,但也带来了选择的责任。花时间测试和比较不同模型在你的特定工作流中的表现,找到真正适合你的配置。

【更新日志】Cursor自定义API配置指南

hljs plaintext┌─ 更新记录 ──────────────────────────┐ │ 2025-03-06:完整更新,适配v1.8.4 │ │ 2025-02-15:添加Claude 3配置示例 │ │ 2025-01-28:新增本地模型配置部分 │ └─────────────────────────────────────┘

🎉 如果本文对你有帮助,别忘了收藏页面并定期查看更新。Cursor和各大AI模型都在快速迭代,我们将持续更新本指南以保持其实用性和准确性。