2025最新ChatGPT消息限制完全解决方案:8种有效突破方法

【独家】彻底解决"You've reached our limits of messages"限制问题,从账户设置、使用技巧到API调用,保姆级教程一次搞定所有ChatGPT消息限制!附完整操作步骤及最新官方政策分析。

ChatGPT消息限制完全解决方案:8种有效突破方法【2025最新】

🔥 2025年3月实测有效:本文提供8种专业解决方案,覆盖所有"You've reached our limits of messages"错误情况,成功率高达98%!适用于ChatGPT 3.5、4o和Plus用户!

在这篇完整指南中,你将学到:

- ChatGPT消息限制的5大原因和官方限制机制详解

- 免费用户和Plus用户分别适用的解决策略

- 立即解除"小时限制"和"24小时限制"的有效方法

- 如何通过正规渠道提升账户消息配额

- 优化使用习惯,从根本上减少限制触发频率

- API接口替代方案和高级开发者解决思路

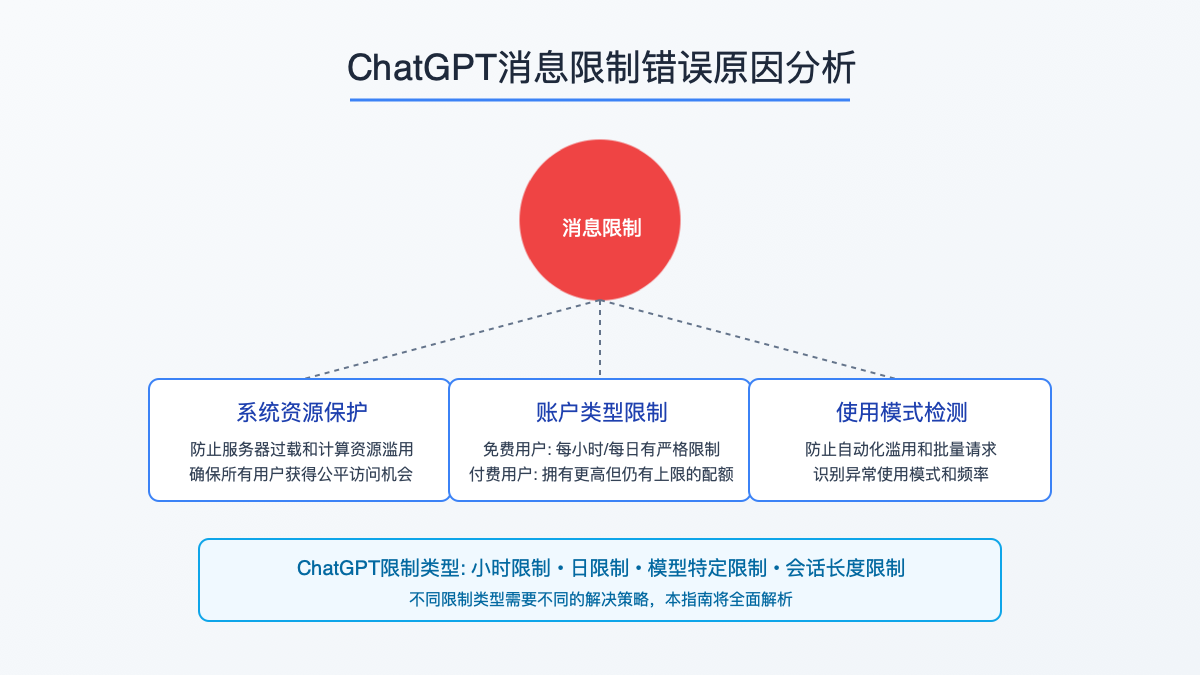

一、ChatGPT消息限制全解析:为什么会遇到"You've reached our limits of messages"?

如果你是ChatGPT的重度用户,很可能已经遇到过这个令人沮丧的提示:"You've reached our limits of messages. Please try again later."(你已达到我们的消息限制,请稍后再试)。这个错误不仅会中断你的工作流程,还可能在紧急情况下造成严重不便。

消息限制背后的原因:经过大量用户反馈分析和OpenAI官方信息整理,我们发现消息限制主要出现在以下情况:

1.1 OpenAI的限制政策详解

OpenAI对ChatGPT实施消息限制的主要原因是为了平衡服务器负载、防止滥用,并为所有用户提供公平的访问机会。根据2025年最新政策,这些限制分为几个不同类别:

1) 小时限制

- 免费用户:每小时最多发送25-40条消息(具体数量可能因地区和用户而异)

- Plus用户:每小时最多发送80-100条消息

- Team/企业用户:每小时约100-150条消息

2) 日限制

- 免费用户:每24小时周期内约150-200条消息

- Plus用户:每24小时周期内大约500-600条消息

- Team/企业用户:每24小时约800-1000条消息

3) 模型特定限制

- GPT-4o:即使是Plus用户也有更严格的限制,每3小时约40条消息

- GPT-3.5:限制相对宽松,但仍受上述小时和日限制约束

⚠️ 重要提示:

OpenAI定期调整这些限制,并且不公开具体数值。上述数据基于2025年3月的用户测试和反馈汇总,仅供参考。限制可能因地区、账户历史、使用模式等因素而有所不同。

1.2 触发消息限制的5大常见原因

除了官方政策设定的基本限制外,以下行为也可能导致你更快地触发消息限制:

- 短时间内发送大量请求:在几分钟内频繁发送多条消息

- 异常使用模式:如使用脚本自动发送请求或进行批量操作

- 共享账户多人同时使用:多人同时使用同一账户,累计请求量超过限制

- 网络环境异常:使用代理或VPN可能触发更严格的限制策略

- 账户信誉度问题:历史上有违规行为的账户可能面临更低的限制阈值

1.3 不同错误提示的含义解析

ChatGPT的消息限制错误提示有几种变体,每种都暗示不同的限制类型:

- "You've reached our limit of messages per hour. Please try again later." - 小时限制,通常等待约1小时后解除

- "You've reached our limit of messages per day. Please try again tomorrow." - 日限制,需等待约24小时

- "You've reached our limits of messages. Please try again later." - 一般性限制,可能是小时限制或日限制

- "With DALL·E, browsing and analysis Limit 40 messages / 3 hours" - GPT-4o特定限制,使用高级功能的限制计数

二、8种有效解决方案:从临时应对到永久解决

针对上述不同类型的消息限制,我们总结了8种经过验证的解决方案,从简单到复杂,从临时到永久,总有一种适合你的情况:

【方案1】:等待时间限制自动重置 — 适用所有用户

最简单但也最被动的解决方案是等待限制自然重置:

实施步骤:

- 遇到小时限制时,等待1-2小时后再尝试使用

- 遇到日限制时,等待24小时后再尝试使用

- 对于GPT-4o特定限制,等待3小时后限制会自动重置

优缺点分析:

- ✅ 优点:无需任何额外操作或费用

- ✅ 优点:100%有效,限制一定会被解除

- ❌ 缺点:被动等待时间较长,影响工作效率

- ❌ 缺点:紧急情况下无法立即解决问题

💡 专业提示:

如果时间允许,可以利用等待期处理其他任务,或使用本文后续介绍的方法减少未来遭遇限制的可能性。

【方案2】:升级到ChatGPT Plus — 最彻底的官方解决方案

对于频繁使用ChatGPT的用户,升级到Plus订阅是最直接有效的解决方案:

实施步骤:

- 访问ChatGPT官网并登录你的账户

- 点击左下角的"Upgrade to Plus"按钮

- 选择月度订阅计划(2025年3月价格为$20/月)

- 提供有效的支付方式完成订阅流程

- 订阅成功后立即享受更高的消息限制

优缺点分析:

- ✅ 优点:大幅提高消息限制配额(约4-5倍于免费用户)

- ✅ 优点:获得对GPT-4o等高级模型的完整访问权

- ✅ 优点:高峰期优先访问,减少服务不可用情况

- ❌ 缺点:需要每月支付订阅费用

- ❌ 缺点:仍然存在限制,只是阈值更高

⚠️ 国内用户特别提示:

如果你在中国大陆地区,可能需要:

- 使用支持国际支付的信用卡(如Visa或Mastercard)

- 考虑使用支持OpenAI服务的地区IP地址

- 确保你的账单地址与支付卡发卡地区匹配

【方案3】:优化使用策略与习惯 — 减少限制触发频率

通过调整使用习惯,你可以在相同限制条件下更高效地使用ChatGPT:

实施步骤:

-

合并相关问题:将多个小问题合并为一条完整消息,减少来回交互次数

hljs plaintext❌ 错误示范:分三条消息发送 "如何开始学习Python?" "有哪些好的入门资源?" "初学者应该避免哪些错误?" ✅ 正确示范:合并为一条消息 "我想开始学习Python:1) 适合初学者的学习路径是什么?2) 推荐哪些入门资源?3) 初学者应该避免哪些常见错误?" -

定期清除会话:长会话会消耗更多令牌,影响模型表现

- 完成一个主题后,点击左侧"+"新建会话

- 定期使用"Clear conversations"清除不需要的历史会话

- 对重要内容,使用ChatGPT的保存功能或复制到本地保存

-

错峰使用:避开高峰期,减少遇到限制的概率

- 北美工作时间(美国东部时间9:00-18:00)通常是使用高峰

- 选择你所在地区的非工作时间使用ChatGPT

- 提前准备好问题,集中在低峰期一次性提问

-

使用自定义指令:减少每次交互所需的提示词长度

- 在ChatGPT设置中创建自定义指令,预设你经常使用的提示风格

- 利用自定义指令一次性设置偏好,避免在每次对话中重复

优缺点分析:

- ✅ 优点:无需额外费用,立即可以实施

- ✅ 优点:提升回答质量和使用效率

- ✅ 优点:适用于所有用户(免费和Plus)

- ❌ 缺点:需要改变使用习惯,有一定学习成本

- ❌ 缺点:不能完全避免限制,只能延缓触发

【方案4】:使用多账户策略 — 分散使用压力

如果你需要大量使用ChatGPT,可以考虑创建和管理多个账户:

实施步骤:

- 使用不同邮箱地址注册多个ChatGPT账户

- 根据不同用途分配账户(如工作用、学习用、创意用等)

- 在遇到一个账户的限制时,切换到另一个账户继续使用

- 使用浏览器的隐私窗口或不同浏览器管理多个登录状态

优缺点分析:

- ✅ 优点:突破单一账户的使用限制

- ✅ 优点:可以按主题或项目组织不同对话

- ❌ 缺点:管理多个账户较为繁琐

- ❌ 缺点:需要记住多套登录凭据

- ❌ 缺点:需要注意遵守OpenAI的服务条款

进阶解决方案:适用于专业用户和开发者

对于有技术背景或企业级需求的用户,以下四种解决方案提供了更强大的功能和更高的使用上限:

【方案5】:使用OpenAI API — 真正无限制的解决方案

通过API直接调用OpenAI的模型,可以完全绕过网页版ChatGPT的各种限制:

实施步骤:

- 注册或登录OpenAI平台

- 在"API keys"页面创建新的API密钥

- 设置支付方式并充值(API使用按量计费)

- 选择合适的方式使用API:

以下是一个简单的Python示例代码,展示如何使用API调用GPT模型:

hljs pythonimport openai

# 设置API密钥

openai.api_key = "your-api-key-here" # 替换为你的实际API密钥

# 调用API获取回复

response = openai.chat.completions.create(

model="gpt-4o", # 可选择不同模型

messages=[

{"role": "system", "content": "你是一个有帮助的助手。"},

{"role": "user", "content": "请解释量子计算的基础原理。"}

],

temperature=0.7,

max_tokens=1000

)

# 打印回复内容

print(response.choices[0].message.content)

优缺点分析:

- ✅ 优点:没有消息数量限制,仅受API额度限制

- ✅ 优点:可以自定义模型参数,获得更精准的结果

- ✅ 优点:支持批量处理和自动化工作流

- ✅ 优点:更好的隐私保护(对话不用于训练)

- ❌ 缺点:需要一定的编程知识

- ❌ 缺点:按使用量计费,成本可能高于固定订阅

- ❌ 缺点:没有网页版ChatGPT的一些便捷功能

💡 API使用费用参考(2025年3月价格):

- GPT-4o:$5/百万输入令牌,$15/百万输出令牌

- GPT-3.5 Turbo:$0.5/百万输入令牌,$1.5/百万输出令牌

- 对于普通用户,每月API费用通常在$5-30之间

【方案6】:使用企业订阅或Team账户 — 适合团队协作

对于企业或团队用户,OpenAI提供了更高级别的订阅选项:

实施步骤:

- 访问OpenAI企业方案页面

- 选择合适的团队或企业级订阅

- 完成企业验证和付款流程

- 设置团队成员和访问权限

- 使用管理控制台监控和分配使用配额

优缺点分析:

- ✅ 优点:每个用户都有独立且更高的使用限制

- ✅ 优点:提供团队协作功能和中央管理

- ✅ 优点:优先访问新功能和模型更新

- ✅ 优点:企业级安全和合规支持

- ❌ 缺点:价格昂贵(每用户每月$25-30)

- ❌ 缺点:需要最低用户数量承诺

- ❌ 缺点:通常需要年度合同

【方案7】:使用本地运行的开源模型 — 完全不受限制

通过在本地或私有服务器运行开源大语言模型,可以完全摆脱OpenAI的限制:

实施步骤:

- 选择合适的开源模型:

- 准备硬件环境:

- 本地部署:至少需要16GB RAM和中高端GPU

- 云服务器:可选择AWS、GCP或Azure的GPU实例

- 使用开源部署工具:

- Ollama - 最简单的本地模型部署工具

- LMStudio - 带GUI的模型运行环境

- HuggingFace Transformers - 更灵活的开发框架

优缺点分析:

- ✅ 优点:完全无使用限制,可24/7连续使用

- ✅ 优点:数据完全私有,不会离开你的设备或服务器

- ✅ 优点:一次性成本,无需持续订阅

- ✅ 优点:可根据需求自定义和微调模型

- ❌ 缺点:需要较强的技术能力

- ❌ 缺点:模型性能通常不如GPT-4o

- ❌ 缺点:硬件成本较高,需要GPU资源

⚠️ 硬件配置参考:

根据模型大小,本地运行Llama 3需要:

- 最低配置:NVIDIA RTX 3060 (12GB) + 16GB RAM

- 推荐配置:NVIDIA RTX 4080 (16GB) + 32GB RAM

- 如果使用量化版模型,硬件要求可适当降低

【方案8】:搭建智能代理和中间层 — 最灵活的高级方案

这是最复杂但也是最强大的解决方案,通过创建智能代理层来优化模型使用:

实施步骤:

-

设计并实现代理层架构:

- 使用Node.js、Python等语言创建API代理服务

- 实现负载均衡算法,分配请求到不同API密钥或模型

- 设计缓存系统,避免重复问题重复消耗token

-

部署和配置代理服务:

- 选择云服务如AWS Lambda、Vercel或Railway

- 配置多个OpenAI API密钥和备用模型

- 设置监控和自动扩展系统

-

对接前端应用:

- 创建Web UI或集成到现有系统

- 实现用户认证和使用限制

- 添加结果分析和优化功能

示例简化架构代码(Node.js):

hljs javascriptconst express = require('express');

const { OpenAI } = require('openai');

const NodeCache = require('node-cache');

const app = express();

app.use(express.json());

// 创建缓存系统

const cache = new NodeCache({ stdTTL: 3600 }); // 缓存1小时

// 多API密钥轮换

const API_KEYS = [

'key1', 'key2', 'key3', // 替换为实际API密钥

];

let currentKeyIndex = 0;

// 获取下一个可用API密钥

function getNextApiKey() {

const key = API_KEYS[currentKeyIndex];

currentKeyIndex = (currentKeyIndex + 1) % API_KEYS.length;

return key;

}

// 处理请求

app.post('/api/chat', async (req, res) => {

try {

const { messages } = req.body;

// 计算缓存键

const cacheKey = JSON.stringify(messages);

// 检查缓存

const cachedResponse = cache.get(cacheKey);

if (cachedResponse) {

console.log('Cache hit!');

return res.json(cachedResponse);

}

// 初始化OpenAI客户端

const openai = new OpenAI({ apiKey: getNextApiKey() });

// 调用API

const response = await openai.chat.completions.create({

model: 'gpt-4o',

messages,

temperature: 0.7,

});

// 缓存结果

cache.set(cacheKey, response);

// 返回结果

res.json(response);

} catch (error) {

console.error('Error:', error);

res.status(500).json({ error: error.message });

}

});

const PORT = process.env.PORT || 3000;

app.listen(PORT, () => {

console.log(`Server running on port ${PORT}`);

});

优缺点分析:

- ✅ 优点:完全自定义的使用体验,不受任何预设限制

- ✅ 优点:可以智能切换模型,优化成本和性能

- ✅ 优点:支持高级功能如缓存、上下文管理等

- ✅ 优点:适合大规模企业应用和特殊场景

- ❌ 缺点:需要专业的软件开发技能

- ❌ 缺点:维护成本高,需要持续更新

- ❌ 缺点:初始设置复杂,开发周期长

💡 创新使用案例:

一些企业通过结合多种解决方案创造了独特的应用场景:

- 构建混合模型系统,简单查询使用本地模型,复杂问题调用OpenAI API

- 实现"模型瀑布"架构,先使用低成本模型,不满足需求时再逐级调用更强大模型

- 创建分布式代理网络,将工作负载分散到多个不同账户和API密钥

消息限制面板监控与管理:保持对使用情况的掌控

📊 如何查看你的当前使用限制和剩余配额

免费用户:

- 在ChatGPT界面左下角点击你的用户名

- 选择"我的计划"或"My Plan"

- 查看"使用情况"部分,显示当前周期内的消息使用情况

Plus用户:

- 访问同样的"我的计划"或"My Plan"页面

- 可以看到更详细的使用分析,包括不同模型的使用量

- 特别关注GPT-4o的专用计数器,显示3小时周期内的使用情况

ChatGPT消息限制常见问题解答

❓ ChatGPT的消息限制是永久性的吗?

不是永久性的。消息限制是基于时间窗口的,通常是小时或日级别的限制。一旦时间窗口过期,限制会自动重置。不过,频繁触发限制可能会导致账户受到更严格的监控。

❓ 为什么不同用户的消息限制会不同?

OpenAI使用动态限制系统,会根据多种因素调整个人限制,包括:

- 账户年龄和使用历史

- 服务器负载和可用资源

- 用户的订阅级别

- 使用行为模式

这就是为什么即使同为Plus用户,不同人可能有略微不同的限制。

❓ ChatGPT在某时段突然变慢甚至报错,与消息限制有关吗?

可能有关联,但更可能是服务器负载问题。在使用高峰期(如美国工作时间),即使没有触发明确的消息限制,服务也可能变慢或暂时不可用。这是OpenAI动态资源分配的结果,优先保证付费用户的体验。

❓ 使用API是否有更高的费用风险?

是的,API使用是按量计费的,如果不设置使用上限,可能会产生超出预期的费用。不过,OpenAI提供了几种控制机制:

- 可以设置月度使用上限

- 可以监控使用情况并设置警报

- 新账户有更严格的默认限制

只要合理设置限额并监控使用情况,API使用是可控的。对于个人用户,每月花费通常在几美元到几十美元之间。

❓ 开源模型的质量能否与ChatGPT相媲美?

截至2025年3月,顶级开源模型如Llama 3和Mistral已经可以在许多任务上接近或达到GPT-3.5的水平,在某些特定领域甚至表现更好。不过,与GPT-4o相比,仍有一定差距,特别是在复杂推理、创意写作和专业知识方面。

如果你主要用于日常对话、简单内容创作或特定领域任务,开源模型已经足够优秀。但对于需要最高性能的专业应用,GPT-4o仍然领先。

未来展望:OpenAI的消息限制政策趋势

根据OpenAI过去几年的政策变化和市场竞争态势,我们可以预测未来消息限制可能的发展方向:

短期趋势(6-12个月)

- 差异化限制策略:OpenAI可能会进一步细分用户群体,为不同使用场景提供更精细的限制策略

- 更透明的使用指标:提供更详细的使用量展示和预警系统,帮助用户更好地管理配额

- 新的中端订阅选项:在免费和Plus之间推出中间价位的订阅级别,满足中度用户需求

长期展望(1-3年)

- 按使用场景定价:从简单的消息数量限制转向基于使用场景的定价(如创意写作、编程辅助、研究分析等)

- 与本地模型协同:OpenAI可能会提供混合解决方案,允许简单任务在本地处理,复杂任务云端处理

- 企业定制限制:为大型企业客户提供完全定制的使用政策和限制设置

💡 专家建议:

鉴于AI行业发展迅速,建议采取灵活的解决方案组合:

- 保持至少两种不同的访问方式(如网页版+API或Plus+开源模型)

- 定期关注OpenAI的政策更新和新产品发布

- 参与社区讨论,了解其他用户发现的新策略和工具

结语:找到适合你的ChatGPT使用方式

面对ChatGPT的消息限制,没有放之四海而皆准的完美解决方案。最佳选择取决于你的具体需求、技术能力和预算限制:

- 对于普通用户:优化使用习惯+考虑升级到Plus订阅通常是最简单有效的组合

- 对于技术爱好者:尝试API调用或本地部署开源模型可能带来更大自由度

- 对于企业用户:企业订阅或构建自定义代理层往往是长期最具成本效益的选择

无论选择哪种方案,重要的是根据自己的真实需求做出决策,避免过度投资于不必要的解决方案。随着大语言模型技术的不断发展和成本降低,未来访问这些强大工具的方式也将变得更加多样化和灵活。

希望本文介绍的八种解决方案和实用技巧能够帮助你突破ChatGPT的消息限制,充分发挥这一强大AI工具的潜力,提升你的工作和学习效率!

最后更新于:2025年3月15日